文档说明

本文档下面的所有内容,是我自2022年4月从华为离职之后,整整一年多的技术思考和探索的过程,这部分不是完整的文档,大部分都是以笔记的形式记载,所以存在不连贯,甚至有些内容我认为太简单以至于不需要记录的时候,这部分甚至都没有内容。

但我仍然把这些内容放在这里,是因为我觉得它对于想深入学习Reality World背后思想的朋友有学习价值

本文的Markdown统计大概有20万字。

1. Introduction

游戏,作为一种模拟真实世界实时运行的系统和机制,它不光在产品形态上跟一般的应用程序体验不一样,例如一般应用程序一般是功能型的,其功能是明确而具体的,而游戏往往是一种体验,没有直观确定性的功能,每个人获得的体验可能都不一样,它的整个程序组织及其开发工具更是与传统的应用程序不一样,例如传统的应用程序通常是按顺序执行,而游戏为了实现对真实实时世界的模拟,需要以一种不间断的实时轮询的机制。这种轮询不光造就了游戏中各个动态系统的实时性,它对整个应用程序的架构,以及这种应用程序的表达能力,都提供了非常不一样的可能性和结果。

多年来,这种应用程序机制主要被用来制作游戏,而游戏这种程序机制的一些难点,通常需要非常专业的游戏公司才能做出不错的游戏产品。而反观传统的应用程序,由于它们的机制更简单,易于学习和理解,因此被更广泛的使用,不仅对人们的生活带来更大的影响,也大大地促进了社会进步。

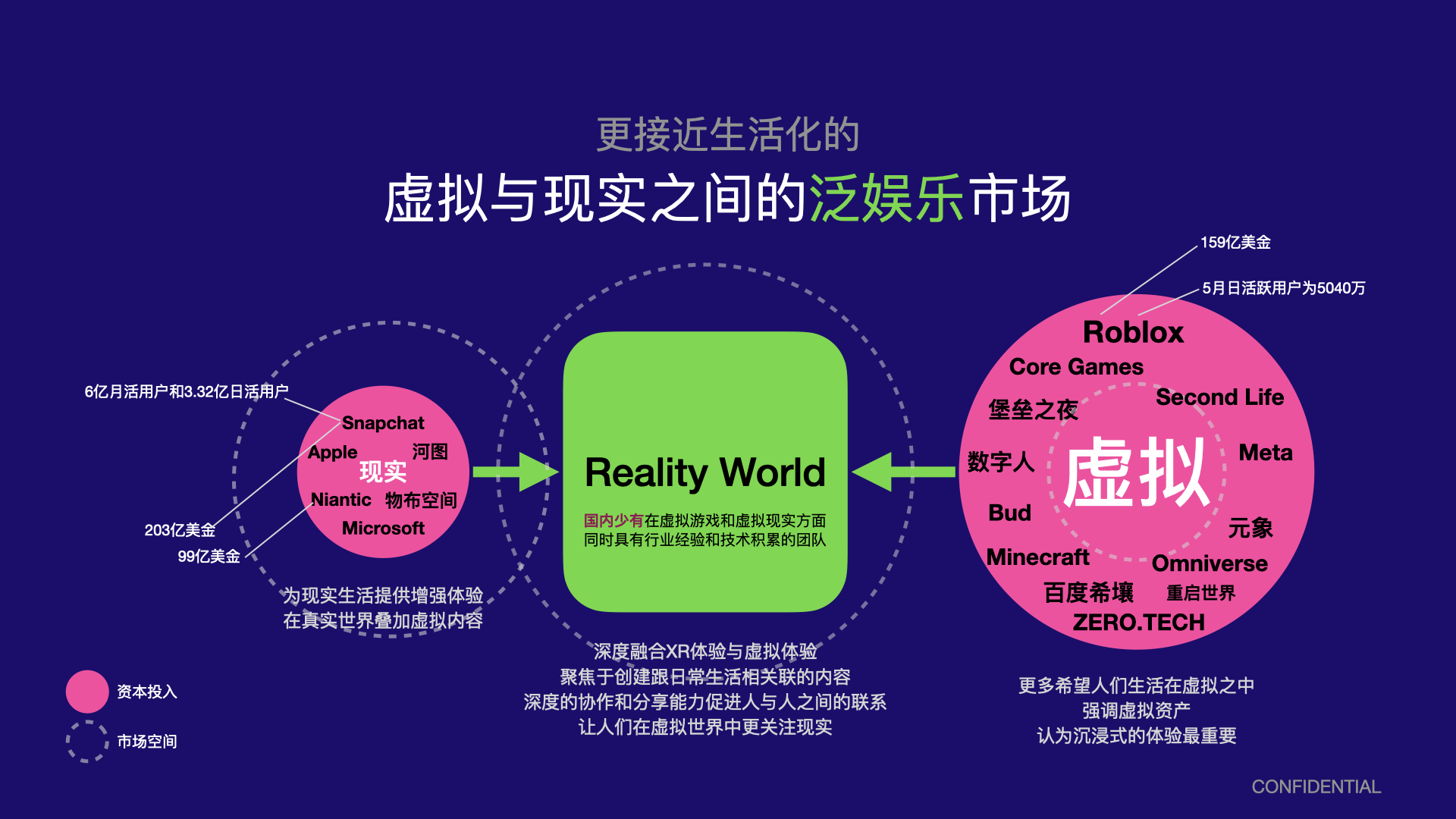

近年来,随着虚拟现实和元宇宙概念和趋势的兴起,这种实时模拟系统越来越频繁被用于到游戏之外更泛化的领域,例如:

- 通过手机的AR功能,Snapchat给用户提供了丰富的滤镜体验,不同于传统视频和图片,这些滤镜是交互式的,用户可以基于这种交互能力生成还富有表达能力的视频,借助这种能力,Snapchat迅速称为一款流行的社交应用。

- 同样是基于手机AR的功能,Niantic借助手机后置摄像头的视觉定位能力(VPS),开发了诸如Pokemon Go等应用,这种新的基于真实地理位置的应用跟人们在真实世界中的活动联系起来,并借助3D互动的能力,把人们的生活联系得更紧密,是一款典型用于增强社交关系的应用。

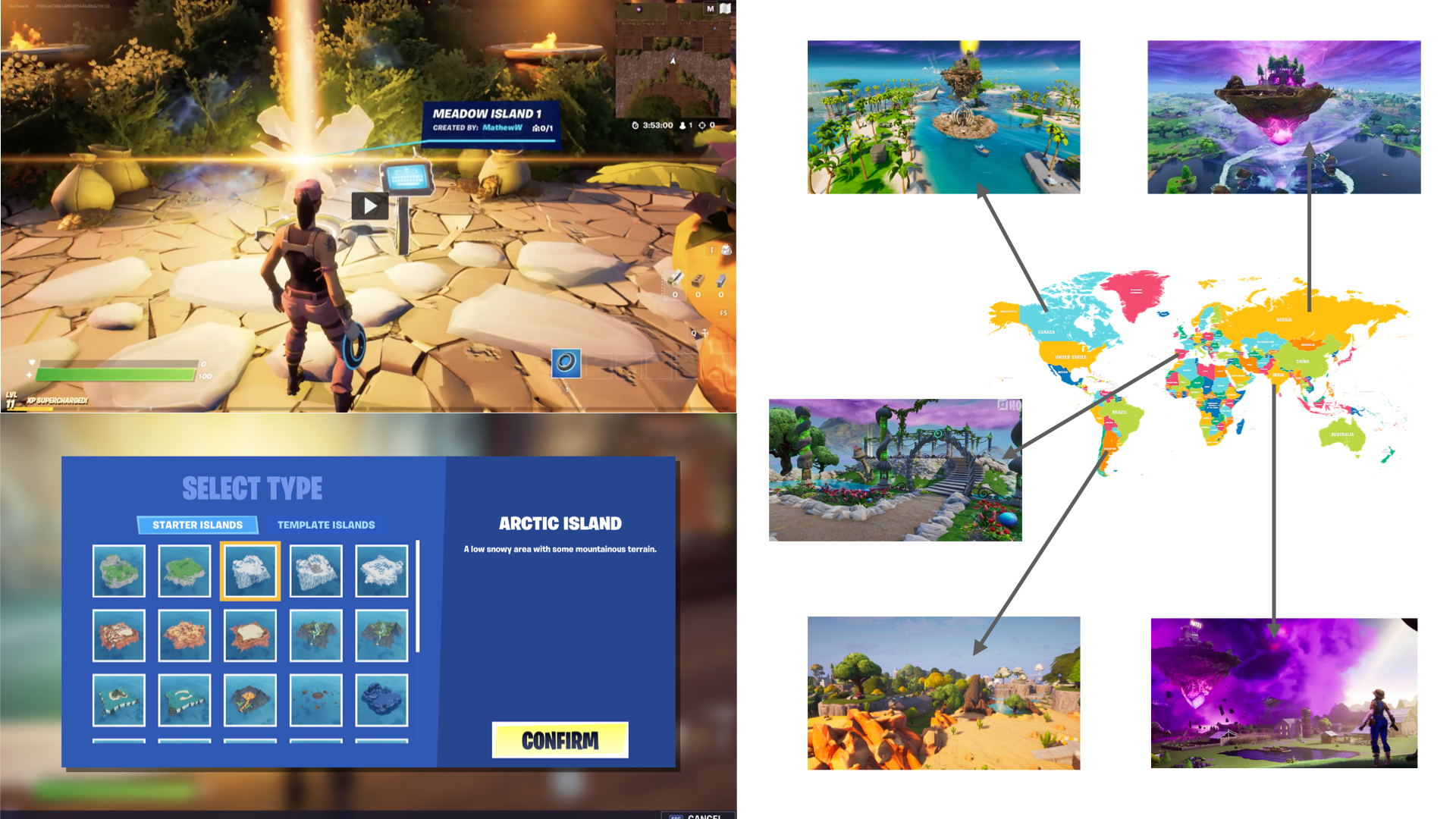

- 以Roblox为首的创作类工具,通过简化程序分发和部署、提供统一的多人在线等服务,降低了游戏开发的门槛,使得更多的中小个人创作互动内容更加简单。并通过云原生的多人在线,使社交游戏的效果被放大,成为未来的重要趋势。

- 由类Minecraft沙盒机制延伸的大逃杀沙盒游戏《堡垒之夜》,借助更好的多人在线服务,例如包括对多人实时游戏更友好的在线语音服务等,使得社交属性在《堡垒之夜》被进一步加强。更好的多人在线服务以及堡垒之夜本身逃生类游戏更好地协同机制,使得堡垒之夜的社交属性称为体验最好的社交属性,其开创和举办的虚拟派对Marshmello更是掀起了虚拟演唱会的热潮。

所有这些变化和发展,对互动内容的开发及生态都带来了巨大的影响和变化,这些影响和变化后面,需要全新的技术范式,而这些新的技术范式又将创造增量的价值和体验。

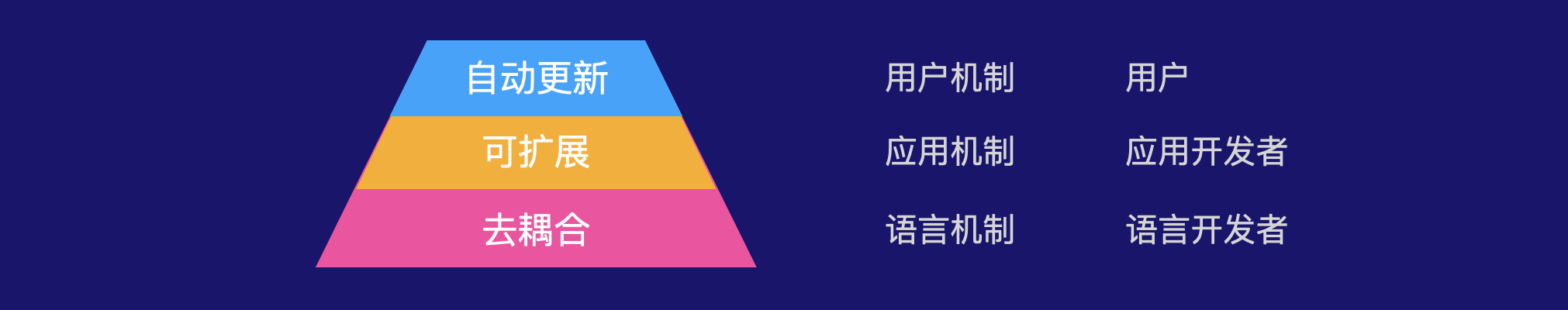

1.1 变革

1.1.1 形态变化

上述这些变化,从上往下看,可以归结为三个维度的变化:

- 开发者:由专业开发者向普通用户转移

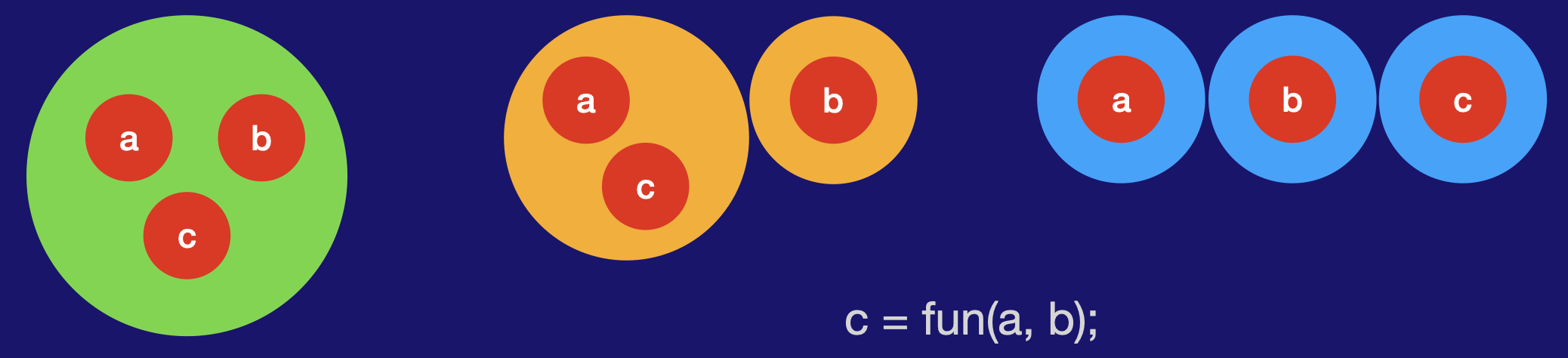

- 开发方式:互动内容的开发方式由完全开发到基于事件驱动开发

- 玩家体验,由完全操控到XR辅助

在开发工具方面,Roblox和Snapchat的Lens Studio都面向普通开发者,它们共同的特点包括简化的脚本,以及一键发布,使得开发者 不需要花费很大的精力去处理平台相关问题。另一方面是这类工具都是深入集成平台的特定功能,例如Lens Studio底层的AR场景理解算法,以及Roblox内置的多人在线服务。深度集成平台与算法,相比于传统通用游戏引擎,将成为未来的一个方向和优势。

在开发方式方面,传统的流程需要开发者定义所有的逻辑,包括触发逻辑的机制,这部分尤其复杂。在Snapchat基于AR的互动内容开发中,这类互动内容的驱动完全来源于手机对场景理解,这些都由AR算法来提供,因此开发者不需要处理任何交互驱动方面的逻辑,而只需要关系对交互的响应逻辑。这种方式不仅大大简化了整个互动内容的开发,也从根本上对互动内容开发的流程带来了很大的变革。简化逻辑开发的触发机制,触发机制数据化,深度与平台集成,是未来互动内容开发走向平民化的重要方式 之一。当然在这个过程中,基于代理的物体位置摆放机制也起到了很大的辅助作用。

同样借助与事件触发机制的数据化,以及基于XR设备对场景的理解,用户对互动内容的部分操作,由原来主动、精细地控制虚拟摄像机和物体,变为基于场景理解算法的自动驱动,这大大简化了交互成本。

这些各个层面的变化,最终都会导致整个互动内容的制作流程会发生较大的变化。

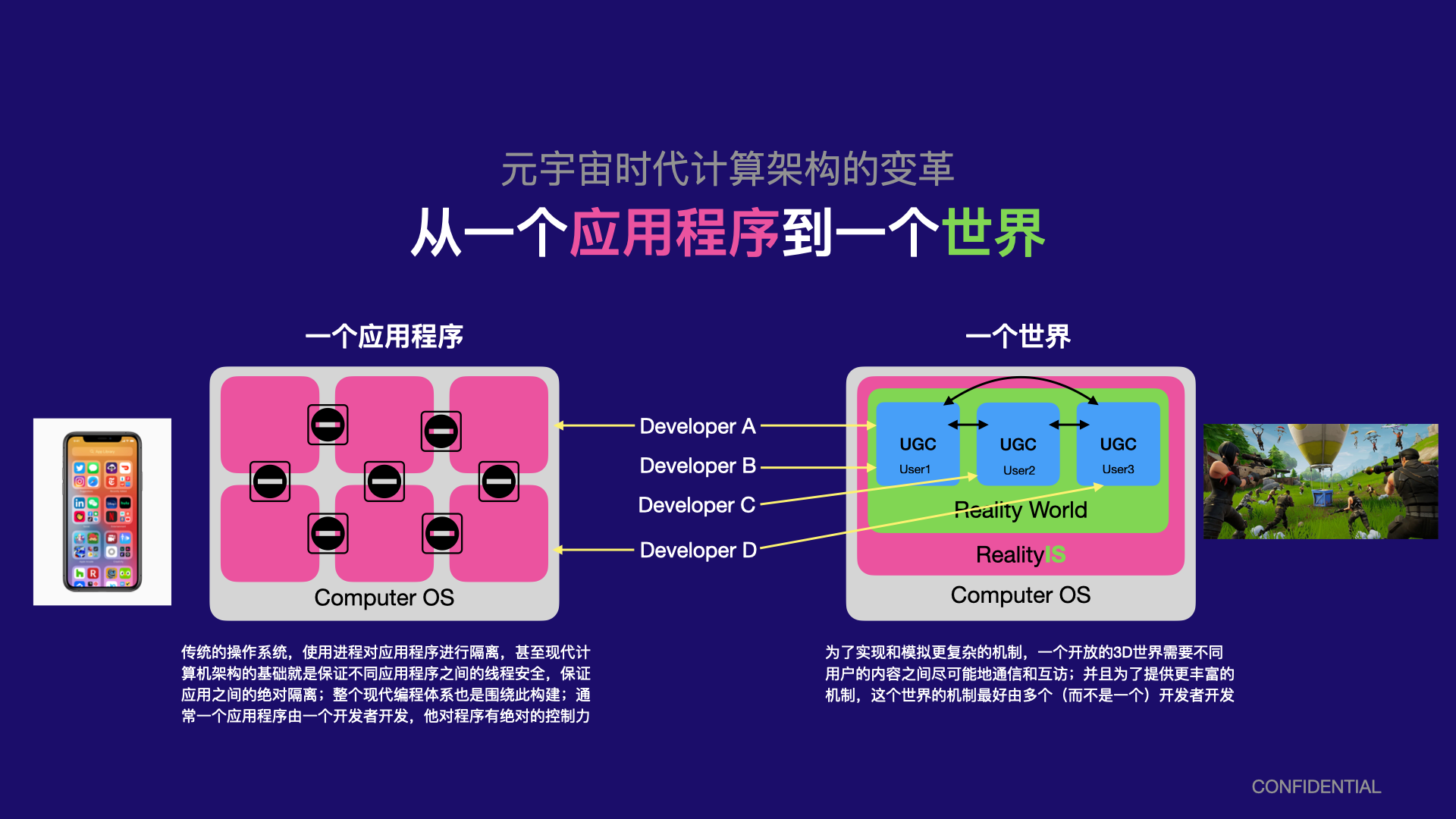

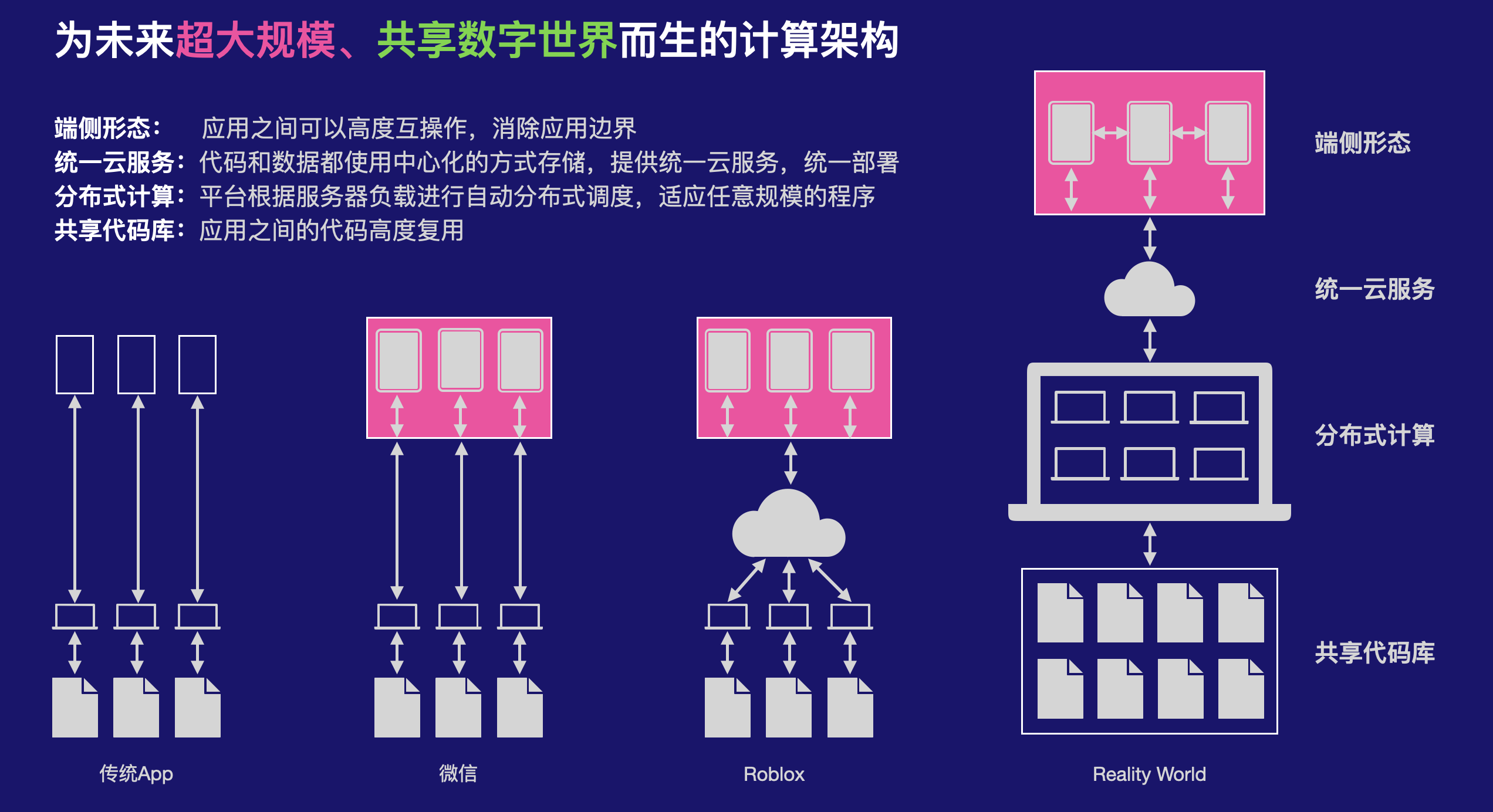

1.1.2 计算架构的变化

从开发的角度,从下往上看,这带来的是计算架构的变革。

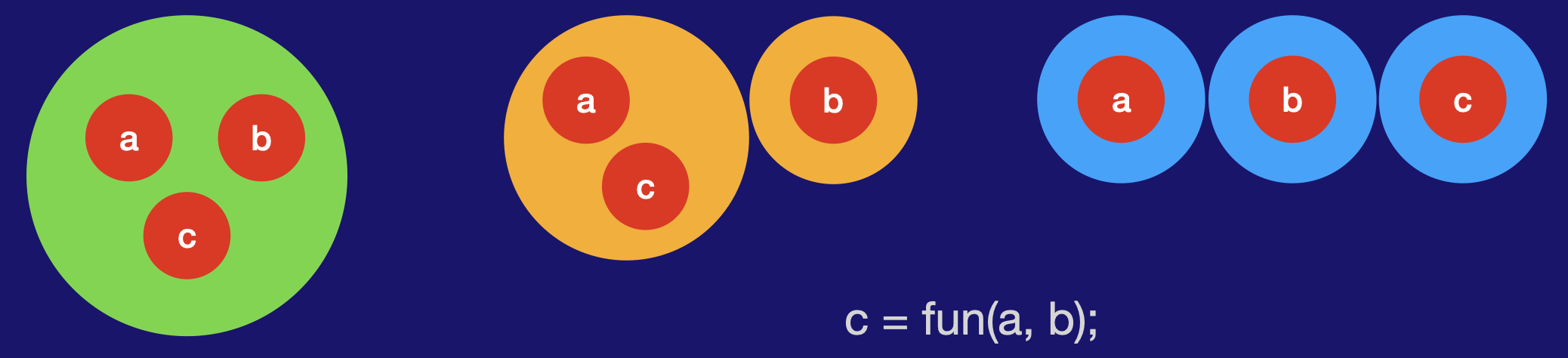

传统的计算架构都是为单个应用程序设计的,从硬件到软件,所有一切流程和功能都是针对这个模型设计的,例如一个应用程序的所有源码都会被编译和链接到一起,一个应用程序内的数据可能相互引用,所有需要链接器来重新定位每个引用变量的地址。这样的计算架构,非常适合于处理具有独立功能的应用程序。但它有比较致命的缺点:

- 例如因为所有源代码编译的目标代码都会链接到一起,所以它们从根本上就不支持大规模应用程序,因为这样的应用程序可能由海量的源代码组成。

- 由于源代码之间相互引用,因此它们很难支持应用程序内的独立子程序通信,子程序之间总是需要引用源代码才可以通信,这使得一个应用程序无法成为一个可以自我进化的开放系统,而总是需要一个开发商来进行维护

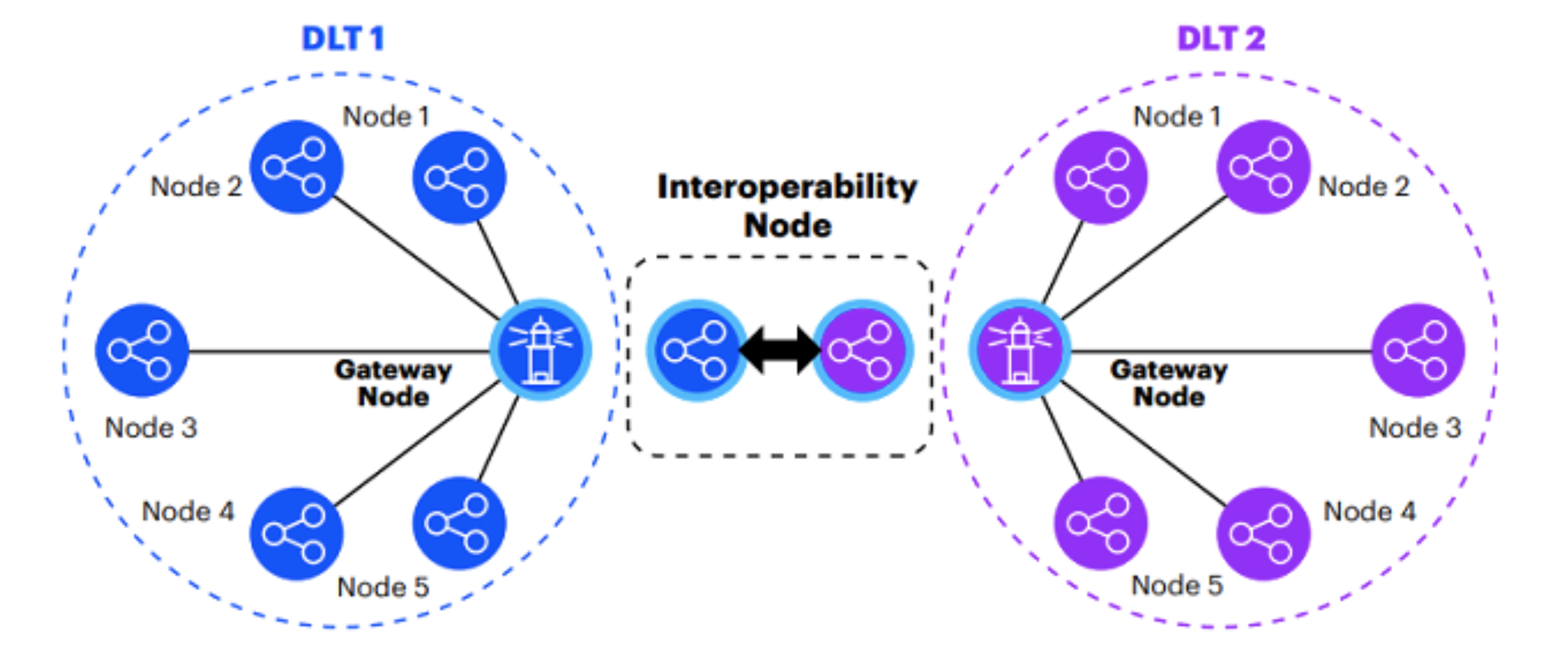

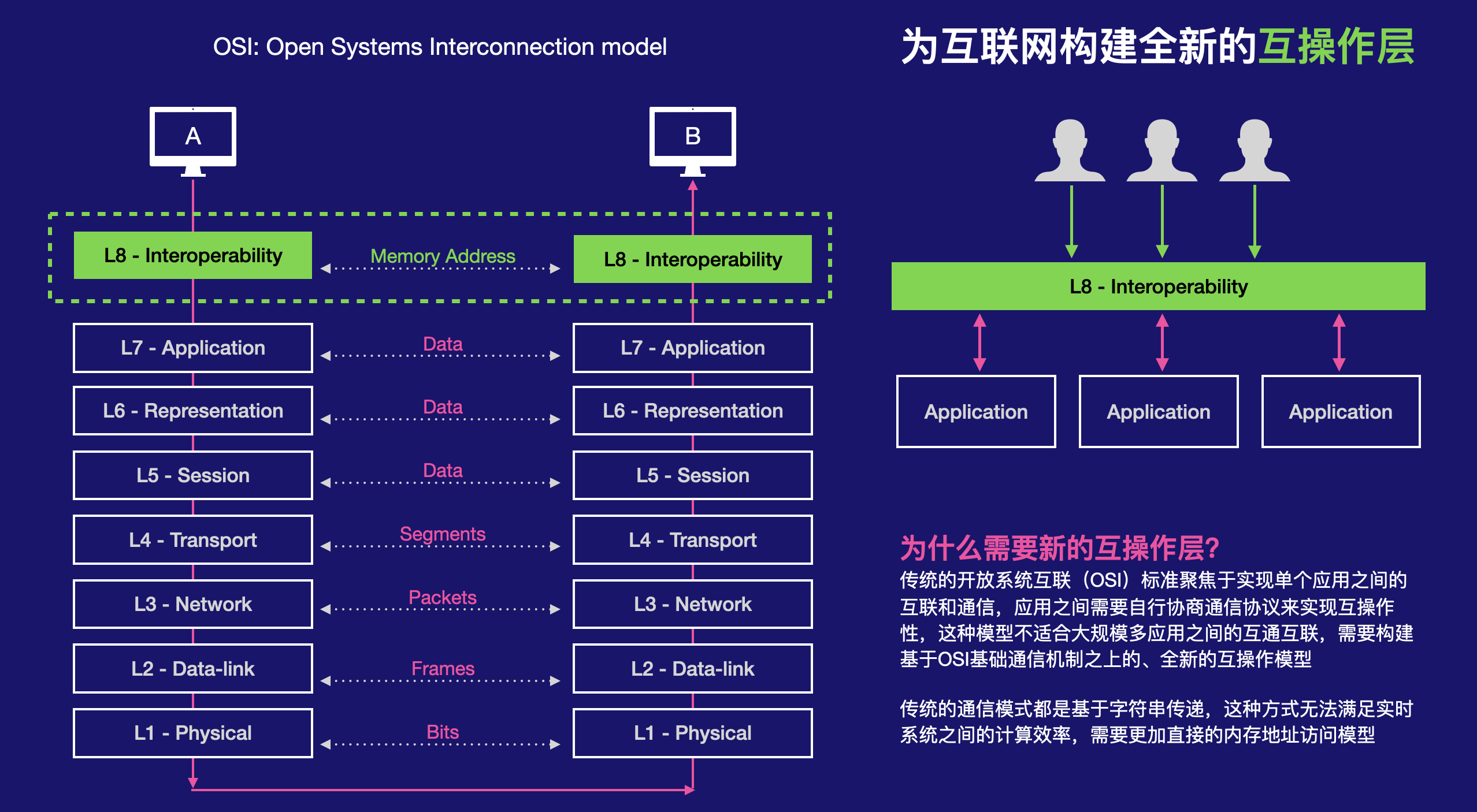

随着UGC和元宇宙时代的到来,这种大规模的、具有内生开放子系统的多应用交互架构越来越成为最核心的需求,这需要我们在计算架构上做出较大的变革。

1.1.2.1 业务比喻

比如现在腾讯有非常海量的业务,比如微信,音乐,视频等,目前这些业务之间相互是比较独立的,他们组织为相互独立的应用程序,相互比较独立的数据管理,服务器架构和组织,虽然彼此之间存在一定关联,但是这种关联是高度结构化和规则化的,且关联很少。

开放世界则意味着,现在所有这些业务需要在一个应用内组织,它的复杂度是非常高的,架构也非常复杂,数据管理和分布式计算都非常复杂,并且由于传统游戏的逻辑组织方式,在这种体量下根本无法有效管理组织和进行分布式计算

可行的思路:

- 微服务化

- 函数式编程

微服务化是一种软件架构,需要高度依赖于对逻辑的设计和划分,他不是一种基础编程模型,因此无法支撑开放式的设计,这些微服务通常都只能是开发商设计好的,普通用户没法修改,因此本质上不支持开放世界。

1.1.3 技术挑战

从根本上,上述的一些变革带来的技术挑战包括:

- 需要全新支持多应用相互通信的计算架构

- 能够在所有计算轻松在多个服务器之间进行分布式计算的数据和计算架构

当然由这两个底层根本性的挑战,上层还包括一些其他挑战,比如独立程序之间高效的通信标准或者机制,用户对权限控制与代码的分离,普通用户怎样无代码编程等等,我们将在后面进一步分析。

1.2 现状

不能随时随地高效的内容创建,与随时随地方便的将创建的内容进行社交分享,是当前最大的问题,或者说是3D数字世界发展的一些重要基础;前者的难点在于它需要编程(通常需要面向对象的编程能力),所有逻辑都是通过面向对象的方式创建出来的(大部分人都不具备);而后者的难点在于它需要一套新的支持分布式协同编辑和分发的底层数据格式表述,这与当前大部分引擎私有格式都不一样

1、主要基于场景理解

当前大部分AR应用都是基于场景理解的简单特效/滤镜呈现,以及围绕这些滤镜非常简单的交互,没有围绕场景构建做太多事情,即堡垒之夜的方式,包括更复杂的交互

2、3D内容分发

当前大部分不能分发3D内容本身,而是分享录制的视频;或者只是分享相同的滤镜给朋友,使用体验没有差异性

3、用户创建参与感很弱

绝大部分都是场景理解驱动,仅有纯视觉的体验,没有3D真正复杂的交互和创建体验

4、大部分聚焦虚拟空间

元宇宙即社交方向行业大部分在做虚拟空间:元象、RecRoom、monoAI等

5、3D创建的价值/Minecraft

除了精心的游戏规则设计(这需要很高的开发技巧和能力),3D内容的创建本身也是很有乐趣的,而能够创建自己设计的一定规则的内容就更有趣

大部分没有集中于面向普通用户创建3D内容的能力或体验,Roblox 面向有一定经验的开发者,并且开发模式本质上与传统游戏开发类似,只是分发机制不一样,NV和太极面向用户创作,但是没有面向移动端,而且是纯内容创作

6、底层创新

当前普遍聚焦上层架构,围绕怎样将传统游戏的流程和体验往元宇宙上靠,其结果大多数虚拟空间类产品,聚焦底层协作的主要是Omniverse和太极,其中深入底层性能的只有太极,但在中间层上下协同方面缺乏重点创新,其中太极和元象都在主打云渲染,太极还强调在线协同编辑,Omniverse则支持一般的协同编辑

7、虚拟空间也主要是纯视觉体验

大部分只是在里面行走,不能做太多事情,更不能创作,或者有的也是固定规则的交互,例如Roblox 里面的一些模拟经验的游戏

8、游戏更新的时间

一般需要重新发布的流程,Ubisoft Scalar试图通过云端微服务架构实现及时更新,另外云原生基本上天生就是及时更新的,因为它的资源都在云端

1.3 技术优势

1.3.1 无代码交互内容创作

现在大部分应用都是在设计一个特定场景,提供官方特定的应用、规则或玩法,跟游戏的思路类似,更强调用户的体验

除了游戏引擎,能让用户创作的只有Roblox 只类型的

能够面向普通用户,且针对交互内容进行创作的,只有一家,它是未来最基础的模式和能力,当前没有一家在这个层面,独此一家

用户可以基于RealityWorld 创作游戏,或者简单的作品,跟Roblox 一样,但是它通过两个门槛以及丰富创作的类别,让更多普通用户可以参与,从而大大增加用户群,使得开发者在这个平台上开发游戏有可能具有更大的用户群

1.3.2 代码复用机制

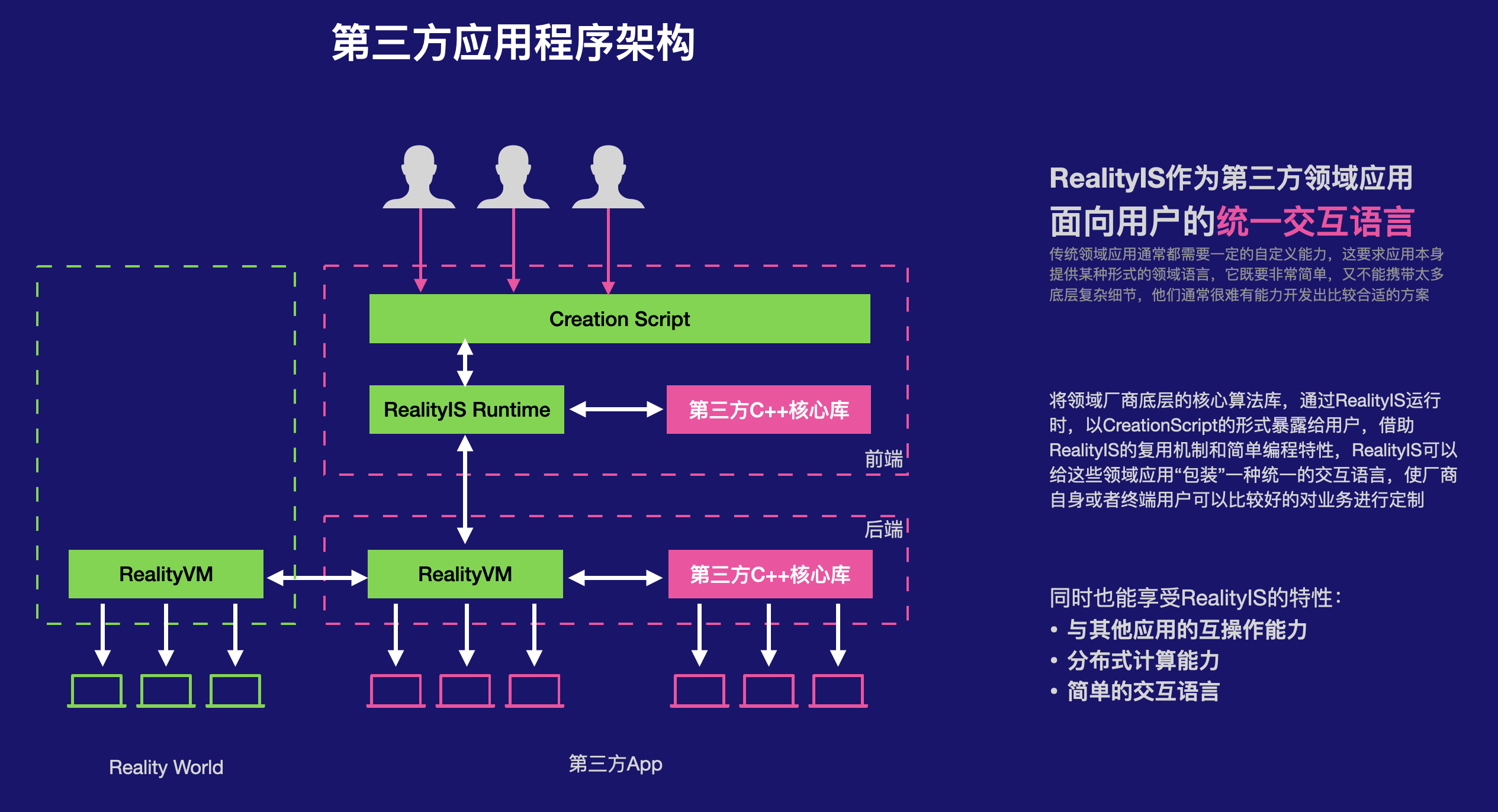

CreationXR runtime,可以被任意第三方app集成

他颠覆了传统开发者生态的方式,传统的小程序或者Roblox 或者Snapchat 只能集中式,只有平台一个入口,而像Niantic 这种仅开放底层能力:

- 开发者接入实际很困难,因为要调用众多的API

- 每个app接入的方式存在冗余,重复,这部分可以共享

- 每个app接入的方式不一样,因此每个app开发的功能本质上类似,但是3D部份却要重复开发,例如要接入预览流等等

- 无法在自己的app里面共享一套开发标准,Unity不算标准,因为他更偏低层,没有定义太多规范,导致每个人开发不一样,而RealityCreate 是高度规范化的

这使得第三方开发者可以共享RealityCreate 高度规范化的流程,又可以最简单的成本和方式接入自己app,从而是开发者聚焦创作本身,同时能享受云原生,用户协作等等所有Creation XR得好处

这样也可以避免in-house 引擎的问题,in-house 引擎主要的问题是不能被其他app简单使用,有固定的流程,这样:

- 既可以按照in-house 的做法快速提升自己的差异性,而避免陷入Unreal和Unity 那样的通用引擎

- 又能像Unity一样被用于开发独立应用

- 还抓住了生态

这种模式还有一个好处,除了应用部署本身,他还提供如应用的统计分析等功能,应用的存储,这些原本都是要开发者自己去对接的,传统的应用开发看有多么复杂:

- 开发者自己自己Unity开发app程序,其中包括大量的美术资源和逻辑开发是每个游戏开发者比较重复的

- 自己打包部署,这要求一些平台层的技巧和经验,这些其实超出了开发者对内容的聚焦,除了内容和玩法,一个游戏创业公司还需要花很多资源

- 然后还需要对接各种SDK,包括端侧的和云侧的,而各种SDK都要公司自己学习,并且不同公司之间这些工作也是重复的,但是每个公司都的招人去挖坑,有时候这些反而成为一些小团队比较阻碍发布的一些障碍

- 后期的运维也需要一些精力和人力也自己开发经验的投入

总之,游戏开发团队花了较多的精力在一些繁琐的事情上,而且公司之间的这些能力本可以共享的,开发者本应该聚焦内容开发

原因是因为开发者要自己发布app,所以没有办法去统一集成一些东西,这些东西本身没有标准,很难统一

当然大的应用本身需要更灵活的能力,有太多限制反而不利于开发,但是对于一些小内容,尤其是个人内容,这是可行的,而且个人开发者需要这样的生态

Roblox 就是做了这些事情,应用开发者不需要担心其他事情,但:

- 它不支持Roblox之外的分发

- 它不支持链接的方式分享

- 编程模型不一样

- 主要面向PC和手机,没有针对XR的算法层接口封装

- 编程模型不一样所以不可能支持XR设备创作

- 还是典型的专业开发+普通用户玩的模式,没有普通用户的创建模式和创造体验

以此为基础,构建微服务架构

美术资源的重复问题

- 传统互动内容最重要的是玩法、故事,美术相对不是最核心的

- 美术资源能够提供独特的视觉语言,但是这些视觉语言更多是风格化的类型,例如在同一种写实风格类型下,玩家对不同的场景感知的差异就会小很多

- 美术场景通过程序化生成方法是能提供较好的差异性和独特性的

- 如果这种程序化方法更加支持风格化,那么就能满足上述的需求

- 风格化主要表现为纹理或者基础材质,有时网格也有一定的差异,但是这都可以进行研究

1.3.3 高性能、低功耗

现代游戏程序通常基于OOP进行开发,其中的引用关系错综复杂,对现代内存硬件架构极度不友好,需要重新对游戏的运行时内存数据进行更好的管理,并且这些管理又不能给开发者带来成本。

参见2.3.1节。

1.3.4 大规模并发、分布式

基于上述相似的原因,现代游戏程序无法使用大规模并发的需求,例如单台服务器最多只能支持上百人同时在线。这主要是游戏程序内的程序和数据耦合度非常高,导致单台服务器必须加载所有的数据,这样的方式不管单台服务器的内存不够,也会带来多台服务器重复加载,以及重复加载导致的数据同步导致的复杂问题。

参见2.2.13节。

1.3.4 自我进化的标准架构

在一个传统的游戏程序中,所有的逻辑都是包含在程序中不可修改,所有的关卡、剧情等等都是固定的,跟电影比较类似,唯一不同的可能是游戏具有交互性。

当需要更新程序时,通常通过DLC或Mod等机制对游戏进行扩展或增强,但是这两种机制通常都比较受限,因此本质上,至少一个已经发布的游戏其核心体验是很难改变的。

但一个开放的Metaverse不仅需要可以任意添加独立程序的能力,还需要能够像真实世界一样自动筛选优秀内容的能力,否则用户可能很快就沉入很多垃圾或者质量较低的信息当中。

传统的数字经济,这种内容都是需要平台使用一定的算法进行推荐,这种推荐算法一般由用户对自己的内容设置一些标签,然后平台建立一些相关度的机制。

但真实世界却是相反的,它们由每个根据自己的判断和选择,来促进整个世界的进化。参见4.12节内容。

1.4 商业模式

1.4.1 加强朋友间在线互动的最好形式

传统的在线互动有三种形式:

- 视频电话

- 多人在线游戏,如《刺激战场》

- 《Roblox》类的虚拟房间

其中游戏类的多人在线,还是以游戏为主,这些交互通常只是聊天或者语音,有点像在现场一起玩游戏大家可以相互讨论;整体的活动还是以玩游戏为主,互动是辅助的形式。

房间类的交互,相对私密一点,但是这些应用的游戏性往往很弱,比较局限于形式上的在线互动,目的性和娱乐性都不够强。

Reality World相对上述的模式,存在一下的一些独特区别:

- 互动的规则和内容往往是可以由其中一个用户创作的,具有独特性,针对性,比如针对一个生日专门设置的与朋友相关的场景和互动内容;这种独特性使得Reality World的内容更容易在好友之间发起互动

- 可以在互动的过程中进行共同创作,比如你向蛋糕上切一刀下去,所有人都可以看到蛋糕被切成两份,这是因为Reality World的场景多人协作特性,而其他互动的内容是固定的,每个玩家只能体验这些设计好的内容

- Reality World的内容可以即使创作和分享,不需要提交到商店,然后用户下载,只需要马上创作之后发送给好友一个链接就可以及时打开

1.4.2 理想的广告-新型虚拟经济体验

在现代数字经济中,除了视频、图片和音乐这种能直接体验的数字内容,其他的大部分内容,其实体和对应的数字表述都是分割的,例如淘宝都买的商品只是数字化后的一个记录,你必须收到东西之后才能体验。

另一种与之相关的数字经济是广告,广告作为一个展示产品的方式,在真实世界中,它们往往以视频或者图片的形式呈现。然而在这种方式中,广告语产品通常是割裂的,受限于实物需要场地及运输等问题,我们并不能总是在任意一个广告旁边放上实物,使得任何看到广告的人就可以购买。

然而,对于后者才是理想的广告形态:就是广告本身就是产品,或者说广告可以一键直达产品体验和购买。

1.4.2.1 广告本身就是产品

如果广告的产品就是数字内容,而非实体内容,理论上是可以做到这种一键体验的效果的。比如如果产品是一个游戏或者一个应用程序,就可以直接点击下载,这种形式现在很普遍。然而这种方式并不是最好的模式,因为:

- 所有的产品都得开发一个app

- 用户可能并不想要安装那么多app

- 因为每个app安装除了体验产品还有很多额外的负担:注册,登录,进去了解软件的导航功能等等

所以元宇宙是一个更好的广告平台,每个产品只需要设计一个交互,玩家直接体验一下就是。但是现在的技术并不能做到这种体验,这里面的原因:

- 一是平台无法支撑任何开发者自由开发交互内容,往往只能通过平台发布,这样广告能力很受限

- 即使增加了新功能,也需要所有玩家都更新,有时候一个广告只有少数人有体验需求

总之,Reality World可以做到厂商可以任意发布带有交互的广告,然后任何玩家只要看到它,就可以及时体验和购买,真正做到:产品及广告,广告及产品,这种模式有望重塑一个全新的虚拟经济形式。

如果广告的内容是实体内容,仍然可以虚拟化体验,或者通过交互,相比视频和图片更好的了解产品。

见4.6.3节内容。

1.4.3 真正的“市场经济”

即市场会决定哪些东西更有价值,这是与传统数字经济系统根本性的不同,传统的数字经济都需要由平台实现某种推荐或者排序算法,例如微博的信息,知乎的文章,淘宝的商品,抖音的视频,这就要求基于一定的标签,分类等机制,信息发布者需要去维护这种标签分类。

然而真实世界的经济却不是这样的,我们所有的一切不是由类似国家或中央的官方机构决定的,而是靠人们自己的选择,促进整个世界的运转。

类似真实世界公司之间的销售,产品越好卖的越多,售价也可以随市场调整。

而且这种机制促进作品的不断改进,就是iPhone手机一样,而传统的内容都是一次性发布,缺乏对原产品的改进机会。游戏也一般由于太复杂,发布后不会有大的改进。目前这些数字经济跟真实世界的经济都不一样。

可以认为它们都是“结构化”的经济,而不是市场经济。

真正的市场经济会促使和催生更多的好内容,更多的人参与。而传统的数字经济,都是少数人在参与或获利。

在真实生活中,每个人都在参与经济贡献;而在目前的自媒体时代,只有少数人在参与经济贡献,大部分都是消费者。

这有机会使得整个经济系统的活力更大:传统的数字化经济都是靠阅读量类似不准确的机制,在这种机制下创作者倾向于作弊买量,而不是创作更好的内容。此外,阅读量本身是个不准确的度量,例如用户可能只是打开了页面就关闭了,根本就没有深入了解对应的内容。而这种通过“实际使用”而不是“查看页面”转化而来对产品的经济定义,更容易促进用户进行更好的创作,就像真实世界一样。见4.3节更多描述。

1.4.4 以标准和组件为核心的抽成机制

传统的NFT类的数字交易市场,交易的是一个数字内容,是一个拷贝,这个拷贝除非通过一定的手段跟踪转售记录,或者甚至限制转售,很难保证创作者的权益。

而Reality World交易的主要是组件和标准,这些组件和标准并不会拷贝一份,而只是一个引用,然后运行时动态从源头拉取最新代码。所以他天生就可以保证了解使用者的情况,比如一个标准能够追踪到所有使用其标准的组件,也能够追踪到所有使用这些标准的用户。

这样标准开发者不能能够收取所有使用者的费用,并且还有很好的更新机制,通知用户购买相关和最新产品,就像真实世界一样。

1.4.5 持续消费

传统的数字化进程中,数字化产品往往是一次性消费,这导致:

- 软件开发者升级动力不大,对创新及创新的速度是极为不利的,因为新用户会越来越少

- 大量陈旧代码,一方面是平台兼容成本高,一方面是用户使用比较陈旧的技术或体验

需要改变这种局面,才能更大地激活数字消费。

参见4.12.4.3节内容。

1.5 用户

Reality World平台有四种类型的用户,当然这里只从创作层面区分,不涉及商业方面的分类或者逻辑:

- 普通用户:类似于抖音平台只观看视频,从来没有或者很少发布内容的用户

- 创作用户:指只在XR设备上,不借助PC编辑器的情况下进行内容创作

- 开发者:使用PC编辑器Reality Create基于标准进行组件开发

- 标准作者:基于对现实世界的理解提出某种抽象,并将其转换为标准,以及持续维护标准的更新

1.5.1 普通用户

尽管普通用户不进行任何形式的创作,但TA仍然是整个经济系统中很重要的一部分,例如:

- TA都其他创作内容的使用和体验产生消费

- TA通过私人社交网络,产生的对好的内容的主动推荐行为,促进了整个市场经济

当然所有人都是普通用户,并且普通用户也有可能转换为其他创作用户。

1.5.2 创作用户

平台很大一部分技术的架构都是为了创作用户,这是区别其他类似平台的关键。

传统面向普通用户的创作有两类主流方式:

- 《堡垒之夜》之类的沙盒游戏,在这类游戏中,整个世界的规则类型比较一致,比如《堡垒之夜》的堡垒建造与逃生,《我的世界》中的怪物机制等,这些机制内置于系统中,平台提供大量具有固定行为的物件,玩家创作的自由度相对较小:基本上不涉及逻辑本身的构造,只有跟物理位置,物体组合等相关与游戏行为无关的策略

- AR事件驱动的增强现实体验,这些应用以《Snapchat》为代表,它提供一些固定的具有互动体验的道具或者滤镜,用户借助摄像机进行体验;这种体验本身不涉及3D的创作,例如制作一个新的滤镜或者一种新的体验,但是它们产生了一个独一无二的视频内容,并且这个内容是跟自己高度相关的。

《Snapchat》的模板只能在PC端制作,《Reality World》则可以及时创作《Snapchat》类似的模板,并且可以选择更丰富的功能组合。

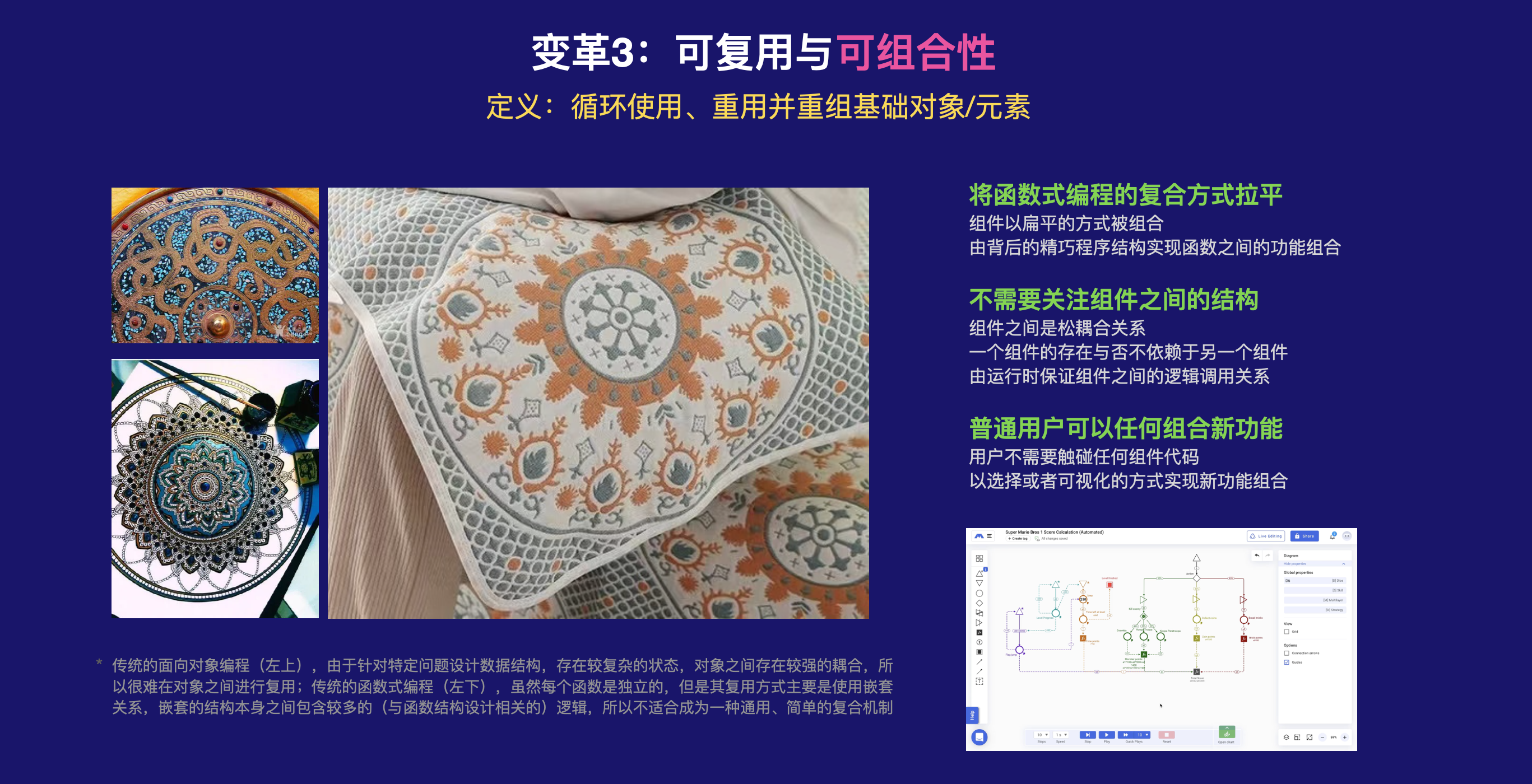

为此,《Reality World》需要支持任意的组件使用,组件之间可以任意协作,这样才能不限制创作,不然就会很容易局限于一个特定的组件包,或者一些特定的互动类型,任意组件之间可以通信和组合是Reality World独特的功能,它能够释放创作者无限的创意。

XR设备上的创作用户必须购买资源,因为他们只能基于已有的资源进行创作,当然有一些资源包或者组件是帮助程序化生成内容的,这类组件可以生成一些随机不固定的内容。资源的类型包括:

- 静态资源:模型(如树木、汽车、弓箭等)、纹理、粒子特效、动画等,Reality World官方应该提供较多的基础资源

- 功能组件,组件是最基本的行为,它们是用户看不见的逻辑代码,它们用来控制物体在游戏世界中的行为;不同组件包之间的组件可以任何组合,创作者需要区分它们的功能,才能生成更好的合理的交互逻辑。这是创作体验的一部分。

- 部件或者物体,由一定的组件组合形成,具有某些特定逻辑功能的游戏对象或者实体,这些实体是直接存在于游戏场景结构中的元素,这些物体可能包含模型、动画、以及能够良好控制这些模型及其行为的组件组合,它们通常是用户直接放置在场景中就可以使用的,类似《堡垒之夜》当中的物体;它们有些也是用于帮助创作一个场景的结构性的组件,例如一个包含TAG的Entity,一个NPC怪物等;也包含一些特殊内置功能的部件,例如Layer表等。

1.5.2.1 一个Creation的创作流程

- 创作者首先浏览Creation商店,下载或者购买一些基本的资源,如上面介绍的静态资源、功能组件和物体等。

- 开发者选择一个物体,将其拖入初始的空场景中

- 然后选择物体对其属性进行编辑,其中可以对其添加组件,组件按类型进行组织,每个组件有结构化的描述及说明,说明应该怎样使用该组件

- 修改组件的属性参数等,组件通过参数来改变物体的行为或者视觉,例如如果是程序化生成组件,则可以生成不同的场景,如果是粒子特效组件,则形成不同的视觉效果

- 播放预览

- 将链接发送给好友

- 好友点击链接加入一起体验

- 如果好友具有权限,可以进行共同编辑,这些编辑也可以是同时在线协同的

1.5.3 开发者

开发者只能基于标准开发组件,一个组件必须支持某个标准,当然一个组件可以支持多个标准,来实现不同标准之间的通信。

标准和组件是隔离的。除来自标准之外的符号,其他符号都是私有变量。

1.5.4 标准作者

某个标准的负责人,当然标准可以转卖,当前负责人不一定是创始作者。

此外,标准不一定需要编程,它仅仅涉及定义与某个抽象相关的数据结构。因此,不具备编程能力,但是具有较强抽象能力的人也可以创建和维护标准。但是从更好的数据结构定义角度,由编程人员维护标准是最合适的,但是编程人员的抽象能力往往不够。所以理想的情况下是某个标准后面有抽象能力较强和编程能力较强两者的组合。

参见4.11和4.12节内容。

1.6 创造增量价值

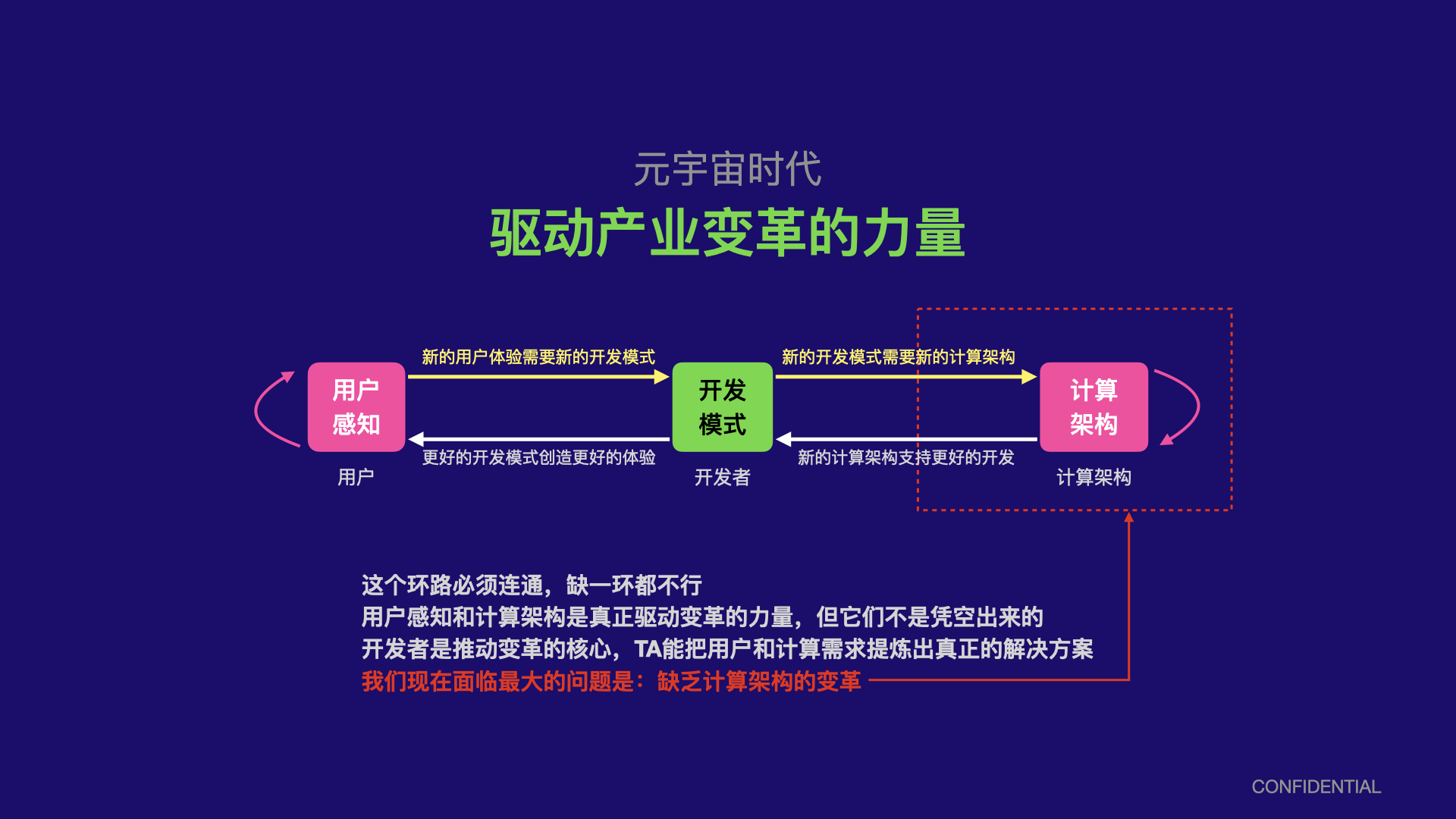

元宇宙代表的不仅是一种新的体验,它将对整个社会甚至数字信息化的进程带来全方位的影响,这种影响不仅仅是一种新的技术或者一种新的功能那么简单,它将包括对计算架构以及全新的信息表述方式这种深层次的变革。

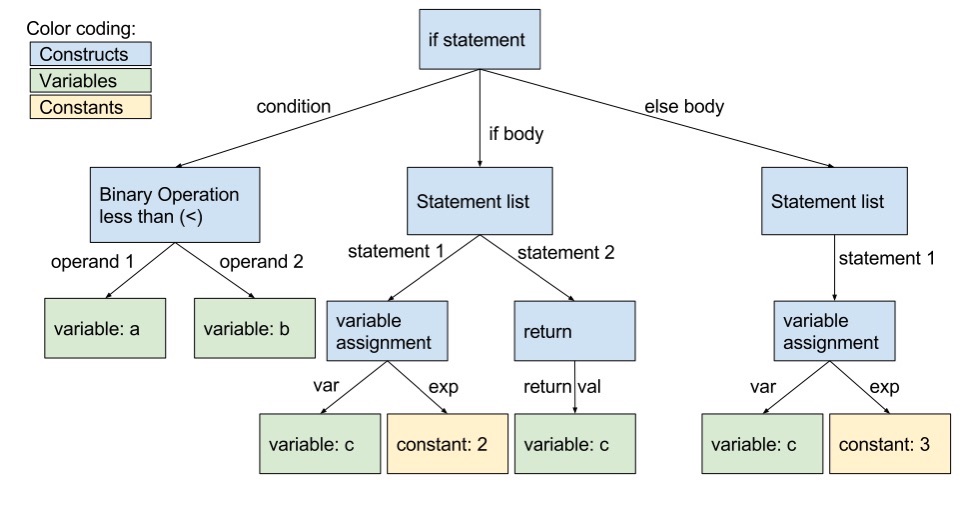

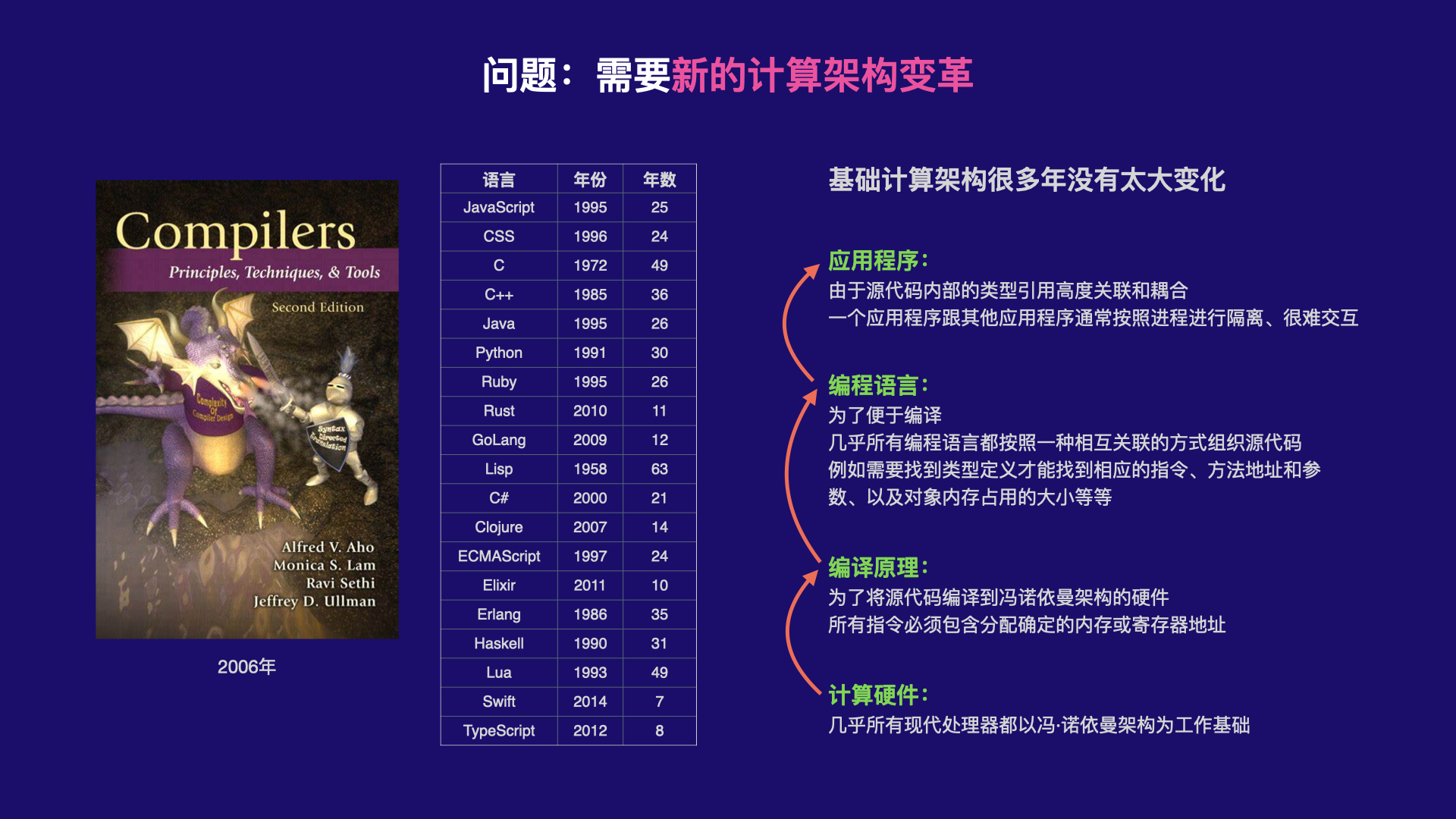

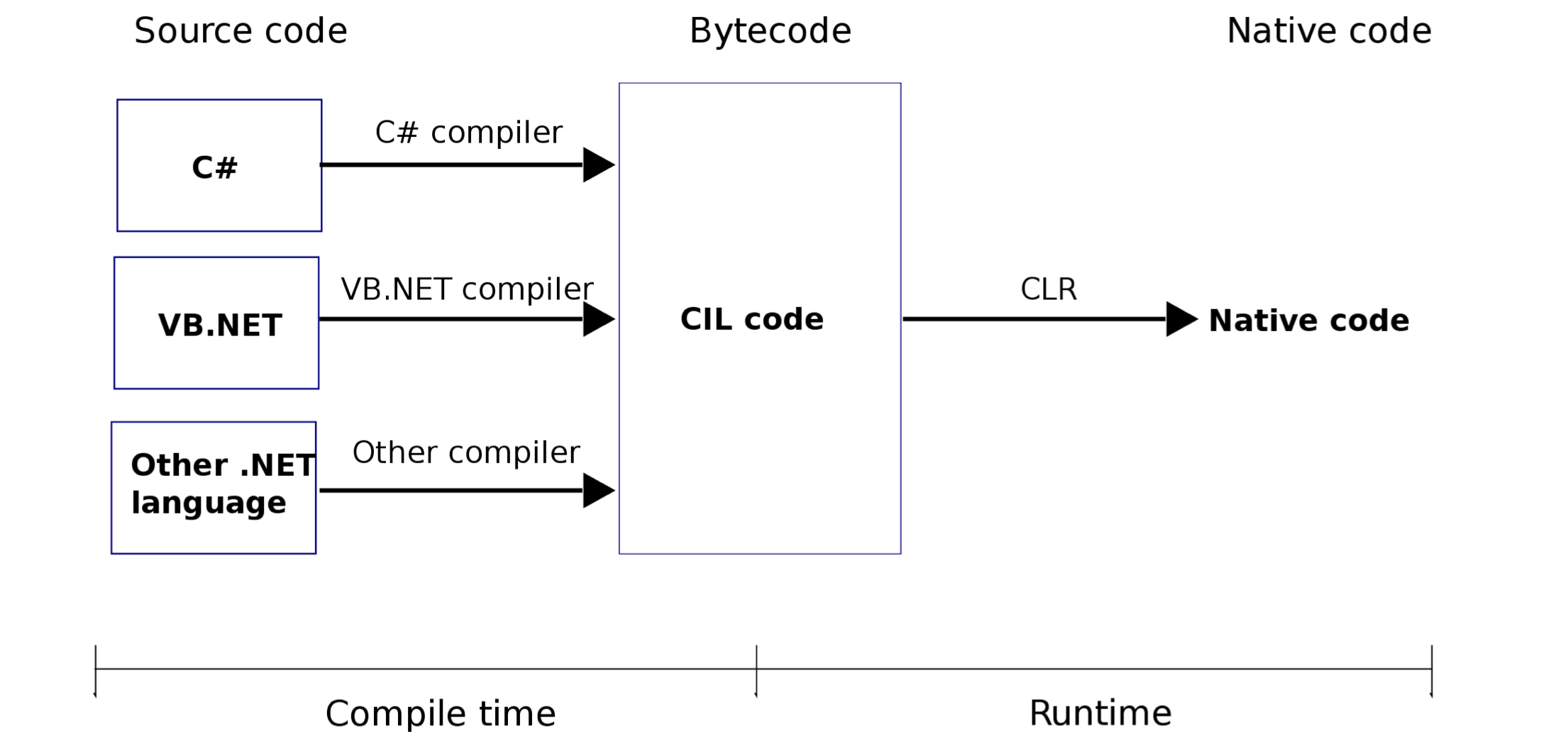

很显然,这种由用户驱动的全新体验需求,用当下的技术架构是做不到的,而且它的限制的根源来源于更底层的计算架构。在近几十年的计算机时代中,底层的计算架构基本上没有发生太根本性变化,例如我们能感知到的:

- 近10年编译架构基本上没有太大变化,一些10年前的经典著名基本上现在还是适用的

- 近10年编程语言的发展也没有革命性的变化,不仅至2010年之后很少推出全新的语言,大部分语言设计也只是针对一些开发体验层面的选择,很多语言的核心思想甚至早在2000年之前就确定

编译和编程语言是计算架构最重要的指向,因为它们连接计算机硬件和应用软件,它们的变革往往能够决定上层软件形态的变革,从而决定技术带给消费者的变革。

当元宇宙带来真正大规模、互操作、大并发等等这些传统计算模型不能应付的需求时,我们需要全新的思路,在计算架构层面创造全新的增量价值,才有机会驱动整个元宇宙的变革。

2. Reality Interoperable System

结构抽象,对于XR端的选择,如果卡包太多,会导致选择操作很复杂,参考淘宝购物,大家会把想买的商品放进购物车,最后一次性付款

让用户在手机端坐好归类,精选出确定或者大概率会使用的组件,然后简化实际的选择,甚至通过更加友好的命名规范来使用语言选择

总之就是需要更好的类型化,并且将用户对资源的选择过程中,融入分类,形成一个天然的筛选过程

定义创作的过程:

- 不仅仅是Create中的时间

- 像备忘录笔记一样随时记录

- 资源的选择准备过程

- 看别人的创作也是创作思考过程

- 甚至逻辑上的组织可能有一部份是非视觉相关的,所以资源管理本身要融入创作过程,即它不光是资源管理,也包含一定的逻辑组织,例如故事大纲结构等等,就像策划在组织表格的时候,比如编写人物故事对话

- 一定不能仅依赖于资源购买+XR端选择这样的传统模式,即交互复杂,也不符合实际的创作流程

2.1 Creation Scene Description

需要加入用户版权信息。

USD的asset resolution机制,使得可以直接加载creation.id的内存,而不需要单独写加载模块,但是需要在自定义resolution中加入权限验证,例如传入消费的app以及用户信息(Reality ID)。

USDZ可能是将一些Behavior转换为Schema,因为这些Schema是C++库,所以需要将USD的C++库放进iOS系统中;虽然USD提供有Python binding,但是它只是接口的封装,因为USD本身也是一门语言,语言本身需要解释或者编译,USD是将新的Schema生成解析的C++文件,所以需要放置在运行时,所以就不能动态定义,只能是系统级别的Schema,开发者通过脚本定义的数据结构还是需要增加一层解析;

为此USD文件中需要包含一些非USD的片段,例如定义一个特殊的Component或者Model,这可以通过asset resolution来与USD一起适配工作。这一部分可以不是USD语言,可以是自己定义的语法;

实际上USD文件不应该让用户看到和编辑,用户看到的是工程或者可视化的描述,或者属性表述。用户或者开发者也不需要编辑这么复杂的结构,USD本质上还是面向数据结构或者程序员的,RW的结构应该更简单、扁平。

2.1.1 分布式存储

对于实体对象的属性数据,可以不采用传统的属性结构进行存储,因为那样就会存储到一个文件,使其存档时会发生并发。

因为其实体对象属性本身是Table结构的,所以我们可以向内存访问一样,每次修改一个属性之后,这个属性利用虚拟内存系统自动存储到硬盘,然后等玩家退出或者程序崩溃的时候再统一存储到用户的数据存储服务器。

这样所有实体对象在云端存储的也是Table,不必存储到一个USD文件中。实际上在内存中它们也不必存储到一个数据结构,例如一个树形的数据结构。只有这样才能保证分布式计算。

将一个IO拆分为多个IO,可能会带来一定性能损失,但是考虑:

- 单个IO或者少数IO只能采用少量线程,如果是大文件解释也会很慢,没法有效利用多线程加载

- 现代NoSQL数据库对缓存,某些查询做了大量的加速,效率要大于单纯的文件或数据区查询

总之,这可以利用到多线程的优势,又能保证分布式。

2.1.2 内存分布式

尽量避免内存中较大的层次性的数据结构,应该都是扁平的,相关性通过组件通信来实现。所有数据都是扁平的。

但对于传统的网格、材质、动画等数据,因为这些数据内部存到大量相关性、引用等,如果将它们存储为扁平的,则解析代码的效率会比较低,通常这种紧耦合的数据都是使用OOP的方式来解析和执行计算。这种数据我们就保留传统的方式,使用USD来保存这些数据。

这样我们存储系统里面会有两类数据:

- 复杂层次结构数据,这部分主要是USD,用来解析传统的模型、动画等

- 简单层次结构数据,这部分主要是逻辑部分

对于其他一些复杂结构,例如状态机、行为树、AI等,如果这些规则是相对固定的,则可以使用单独的格式存储,它们在文件系统中像类似USD那样的文件形式存储,然后实体对象按单独的机制加载它们并进行解析。会定义一些专门的加载以及对其进行操作的组件。

内存中要尽量避免使用层次结构去聚合多个数据,除了像USD这种传统的数据除外,当然对于USD,我们也要尽量利用数据驱动的特性尽量把不相关独立的数据拆开。尽量避免较大的实体对象。

2.2 Creation Script

Creation有一个核心目标:

- 它应该像Lua一样简单,轻量的运行时。

- 它的说明文档只有50页pdf,每个开发者只需要了解这20页文档,不再需要阅读其他资料已学习更高级的技巧。

- 它同时面向专业开发者和普通用户

- 尽可能少的系统层API,不要全部暴露引擎层的API,甚至可以将引擎层的API修改不同的易于业务侧理解的API名字,它的所有API应该像Houdini一样,全部专注于业务,不需要开发者了解的就不暴露给开发者

Creation Script的核心目标是:

- 首要构建一套能够便于普通用户编辑、和共享逻辑的架构;所以他必须能够动态更新

- 次要目标是简化开发者的开发体验,例如只专注于逻辑,而不是复杂的面向对象组织设计,再比如简化多线程的开发,开发者应该感知不到并发编程;例如不能为了方便对Component 进行管理,就要求用户去配置一个包引用文件,而应该自动管理

- 应该是图灵完备的,不能限制开发者的能力

- 他应该基于一个已有的脚本语言,使他专注于上层架构,而不是去构建一套底层语言

- 复杂对象的构建在宿主,脚本主要做轻量计算

- 无垃圾回收,所有堆上的对象均有宿主分配和管理

传统语言几乎都是为了面向对象而生的,所以包含很多为支持面向对象的功能,如果数据驱动是需要的核心,是不是应该有一种新的语言,目前看来Lua更接近这种语言

编译器用途:

- 例如用于检查ECS的结构,不合法的类结构不能被加入到最终程序中

- 例如检查Component 数据内存分配大小等等

- 用于将底层面向对象的能力禁止面向开发者,但是保持底层能力对面向对象的使用

类型检查

TypeScript有很好的的类型检查,但是往往强类型的语言也有一定的限制,例如不允许像lua一样,在同一作用域内相同的变量名称改变类型,另外对于动态语言来讲,一般类型检查这种功能在运行时也是存在的,但本质上这个功能对于运行时不再必须,如果你能保证被检查过的源码没有被修改,一般语言不会把这个功能作为一个可选项

因此有必要设计一种类型检查,它可以被移除,使得仅在编辑时发生作用,而一旦发布之后,实际的运行时不需要这个类型检查的功能,但是还是会保留全部的源代码信息。并且自定义的类型检查可以容许更少的限制。

怎样为Lua添加新的语法

参考TypeScript相对于JavaScript 添加的功能。

Unity DOTS为什么没有默认把System中的并行性指定去掉,是因为他希望兼容传统的Component脚本,而按照传统的写法,没法去控制行为,所以只能开发者实现并行计算。

否则就需要像Roblox一样,需要用户自己将脚本挂在entity上,这就增加了复杂性

所以需要避免让开发者手动将Component与System之间进行关联

Minecraft通过直接在属性中进行编写MOLANG代码来避免该问题

例如开发者看到的文件或者对象只有Component,这样迫使开发者对数据进行抽象;

对于System,我们首先不需要开发者去关联一个Component和一个System,他们应该自动关联,例如通过Component来打开对应的System文件进行编辑

Component除了自身的逻辑属性,另外一些属性用来控制系统结构,例如System执行的顺序等,可以在Component中明确区分两种数据,或者这些固定结构的数据就以一个Component本身的Property形式显示,避免开发者写错

但System可能需要多个Component的数据,因此可以设计为一个System必须对应一个主Component(即使这个Component可能只是一个名字,而并没有任何数据,是有这种情况的,就是某些逻辑本身不包含任何数据,他可能就是一个对多种逻辑进行计算的一个组合逻辑,但是这种应该很少才对,毕竟大部分System应该关心的是自己,其他的是作为查询条件),这样仍然可以将System隐藏在Component中,但是System自身能够指定引用的其他Component作为查询条件,也即是在定义ArchType,可以在System的顶部使用类似。

XXXComponent a;

BBBComponent b;

然后在正文中就可以引用这些对象,解释器会自动将该变量从Entity中进行查询,并且检查如果Entity不包含该Component的时候进行自动添加,当然也可以检查冗余,即如果没有任何使用则不需要添加

但是Component的版本号在哪里设置,使用明明空间加版本号?

BBBBComponent(reality:name,1.2.3)

怎么默认指定?

开发者肯定是先下载了一个包含Component的包再进行编程,但是仍然可能有冲突,所以最好是需要明确指出,而不是自动分配,因为总有一个地方需要明确指出,使用单独的配置文件看起来并不是一个很好的方案

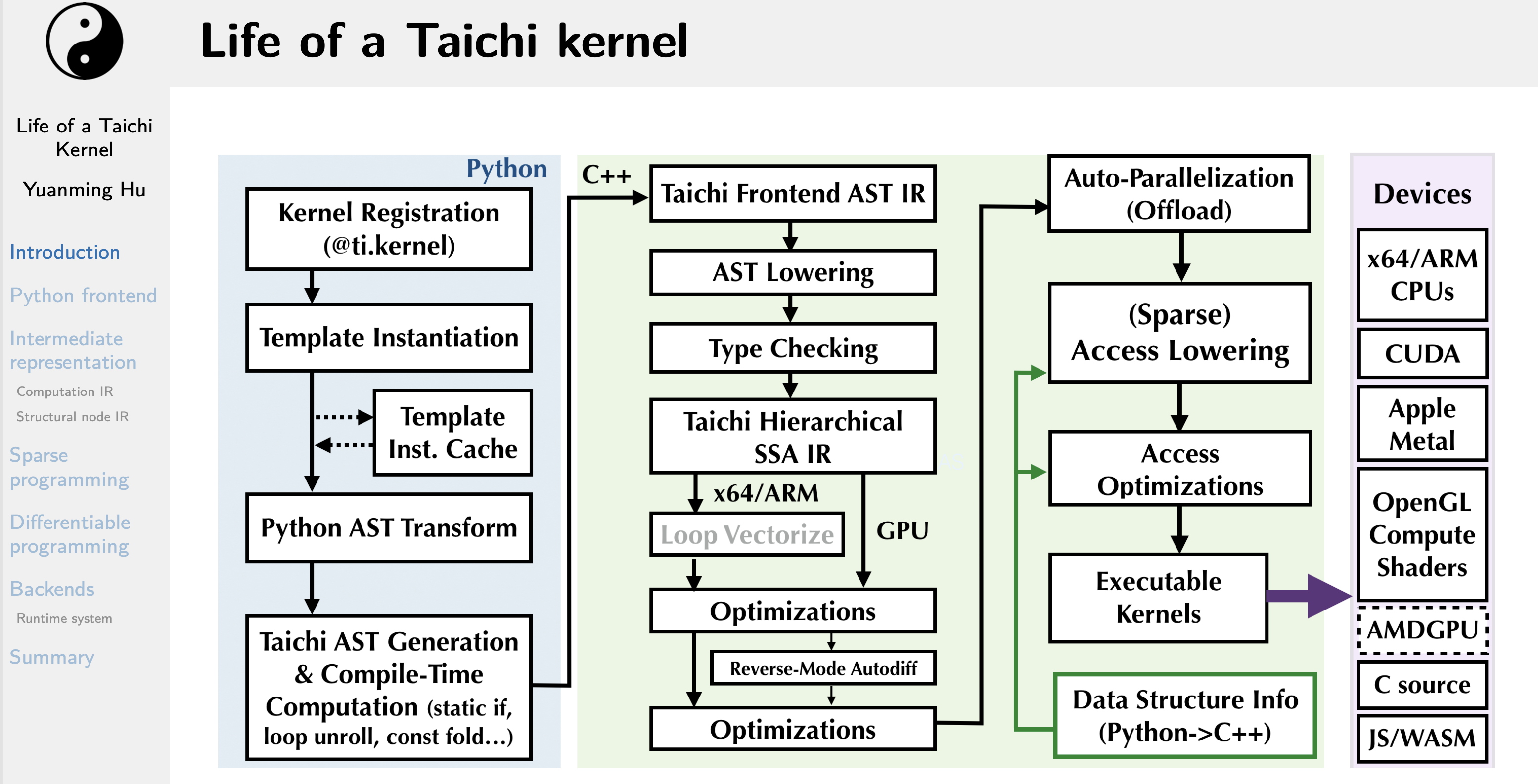

Python嵌入 (Embed in Python)。Python极其易于学习并且被广泛采用。Taichi的前端语法是Python的子集,这使得任何一个Python程序员都能够轻易地学习、使用Taichi。我们使用Python AST灵活的自省 (inspection) 机制来把Python的AST转化为Taichi的AST,随后进入我们自己的编译和运行时系统。将Taichi的前端嵌入进Python有如下好处:

- 容易运行。嵌入在解释性的Python语言而不是编译性的语言中,大大方便了Taichi程序的运行,因为母体语言的预先编译 (ahead-of-time compilation) 不再需要。

- 容易重用已有的Python基础设施并与其交互,包括IDE (PyCharm等)、包管理器 (pip)、已有的Python包(如matplotlib、numpy、torch等)。

即时 (Just-in-time, JIT) 编译。JIT不但提供了极强的编程灵活性,还延迟了”编译期常量“的需求。比如,在物理模拟器中,时间步长 ∆t 通常被实现成运行时变量,而使用JIT的时候则可以被处理成编译期常量。这允许编译器进行更多的优化,如常量折叠 (constant folding)。同时,Taichi支持模板元编程,伴随着JIT的懒惰编译技术大量节省了不必要的编译时间。另外,对于无法运行Python的环境,如移动端设备,我们也提供提前编译 (Ahead of time, AOT) 相关设施

对大众用户、或者偏美术、艺术类用户,最好的脚本语言是什么?图形化的吗?他应该具有两个特征:

- 对一般用户友好

- 适合数据驱动

- 适合DSL编译处理

面向数据编程:

传统的游戏开发是面向事件编程的,例如我们写的所有逻辑几乎都是在每一个frame的某个事件中发生的事情,例如在Unreal的蓝图中,它的起点也是针对某个事件,这有两个缺点:

事件的粒度,游戏逻辑中,几乎主要逻辑都是事件驱动,因此详细的事件非常多,所以大部分都是开发者自定义事件,这些事件由开发者自定义的状态机来进行管理,Framework层只有几个基本的游戏生命周期事件,开发者自定义事件之间没有标准,或者非常复杂,不方便维护

事件与逻辑不一致,像UE的蓝图是基于事件编程,如果我们要把这种能力开发给普通用户,这种没有标准的事件定义并不适合让用去去学习,这些事件通常也没有必然的逻辑联系,不容易理解,例如一个逻辑可能对应多个事件,显然用户需要了解的是逻辑,而非事件

数据代表的是逻辑,所以平台大部分都在设计这种数据,用户也便于理解,同时它代表的不是最小逻辑,而是逻辑模块,所以他将逻辑内部的实现细节(众多的碎片事件)进行隐藏

数据也代表接口,数据的标准有助于构建结构化表达,是逻辑更清晰,以一种更清晰的方式组织

面向数据编程,就像Houdini 中面向Node编程一样,一段Python 代码是受限的,它的输入输出是node ,同时又可以使用到python 本身的任意语言特性和能力;与此类似,面向数据编程也是针对一个特定的“数据”编写脚本,用户编写的是System,他的输入输出是数据Component

但跟传统的ECS架构不一样的是,它的Component 和System之间不是一一对应的,甚至不是自动挂载的,这个机制非常重要,一个Component 理论上可以被多个System消费,当然通常一个特定的Entity实例只有一对Component 与System的组合,因为理论上对一个实例的一个类型的数据,应该只有一个操作逻辑,除非多个System之间逻辑不一样,他们可能偏重数据的某一部份,但是这种情况通常是数据的粒度太大了,可以再进一步细分,当然可能有一些特例需要维持较大的数据。

所以这就使得app包里可能包含一个数据定义的多种逻辑,所以我们不能使用自动挂载,而需要依赖于版本制定,在开发或生成内容的时候,我们将一个System添加至一个Entity,他就生成对应的System引用和版本号,加载的时候是根据这个进行逻辑挂载,当然一个独立的应用本身在顶层也会记录所有引用的Component和System,这样便于预加载

比如如果数据是涉及动画,则数据包含动画时间和当前frame number 等动画信息

把数据当作一个类似Houdini 里面的可视节点,System是另一种类型的节点,拖动任意一个节点到一个Entity会自动加载变量,以及相应的组件版本依赖关系

Creation Script

它的语法部分接近Lua,但是因为所有Table全部由Table Engine接管,脚本中只有索引和基本类型,不存在堆中分配的对象,所以不需要GC

脚本只有简单的计算和函数形式,所有操作对象统一,函数只有简单的数值操作,对象都由底层分配

脚本负责函数内的栈上操作

底层负责堆上内存分配

这得益于统一的数据结构和内存管理

2.2.1 全局变量表(符号表)

符号表的核心意义在于,让不同开发者开发的组件之间可以相互交互,因为如果不是这样,那么我们整个应用程序就只能依赖于单个开发者开发的组件,或者每个开发者开发的组件只能独立工作而不能相互交互(在传统的应用开发流程中,开发者通过变量赋值和引用手动建立起了来自两个不同开发者开发的组件)

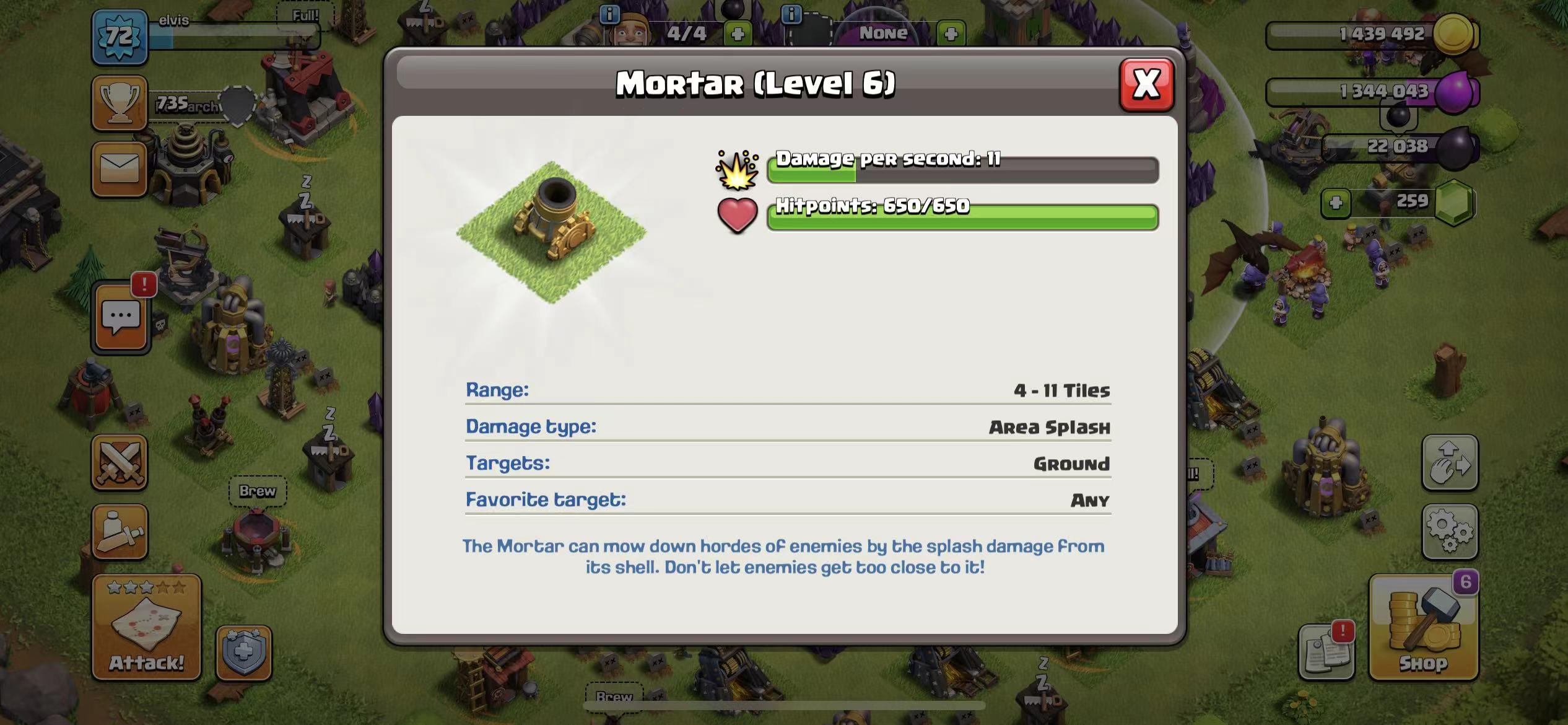

符号表隐含的逻辑是,组件之间的交互涉及的变量应该足够少,大部分应该是内部状态,例如COC中的Cannon:

Damage per second: 11

Hitpoints : 650/650

Range : 4-11tiles

Damage type : Area Splash

Targets : Ground

Favorite target : Any

符号表使我们更加小心地定义我们的变量,使得不那么随意,符号表的全局通用性地位使我们更好地地抽象逻辑,确保设置确实的反应逻辑状态的变量。

符号表使我们更加小心地定义我们的变量,使得不那么随意,符号表的全局通用性地位使我们更好地地抽象逻辑,确保设置确实的反应逻辑状态的变量。

此外,符号表是一种很好的机制,使得我们很容易将一个组件的内部临时变量和对外表现特征的重要状态变量区分出来,逻辑更好清晰。使得代码逻辑更清晰,他人阅读更容易理解。

#version 1.0.0

namespace Global{

iHP //表示血量

iHelath //

iCoin //

vfPosition

sLabelName //用于UI显示名称

}

当然符号表更重要的价值是,实现组件之间相互调用的隐式参数传递,组件之间的依赖通常是比较少的变量,在OOP中这些变量即是两个类之间方法调用的参数,如果我们不区分公共和私有变量,则只要两个组件之间有依赖,就需要加载所有的数据,而实际上有些数据是不必要的,因此它有利于提升性能,只加载每个组件需要的数据。

此外,设置out变量的组件,对应的属性数据会被自动填充,因此避免了手动的变量定义、初始化和参数的传递,这是隐式函数调用的核心机制。当然,开发者应该保证一个全局变量应该同时具有消费者和逻辑处理,否则这个计算可能没有用处,这个通过设计来规避,编译器可以协助提示,因为一个正常的设计肯定是两者都有的;当然也有可能一个组件既充当生产者也充当消费者。

这是最核心的机制,因为如果不这样,要想在两个组件之间进行交互,就必须定义一种协议,这种协议通常就是传统程序语言中的引用机制,因为这样才能保证运行时变量可以识别,这就需要在B中定义公共变量,然后A组件需要引用B组件,这就形成耦合,但是不引用,语言本身的机制没法保证哪怕是同一个名字的变量执行同一个地址。

因此,通过符号表,整个事情变得简化:

- 共享变量只需要定义相同的名字,而不需要引用,这个相同的名字由符号表保证,而不是字符串,因为字符串又设计对应的解析,带来解释负担。而传统编译器中的符号表天生就是用来将多个名字相同的符号指向同一个内存地址。

- 避免了通用语言中只能通过引用来实现参数依赖和传递,而这种依赖是导致没法简化编程甚至无代码编程的根本原因。

当然,符号表机制不适合通用语言,它是游戏这种Update机制相结合才能发挥作用,因为两个Update之间的时间很小,有可能通过帧之间的变量共享来实现函数调用和参数传递。否则这种机制就不生效。

此外,这种机制必须配合解释器或者编译器工作,比如单纯集成Lua或者C#是不够的。

2.2.1.1 动态的符号表

在程序中,符号表应该是动态的,以提升解释的性能。因为符号可能会非常多。

首先在创建内容的时候,根据选择的组件计算所有用到的符号表,然后动态生成一个符号表,这可以是云端的一个接口。

当需要修改实体对象时,重新生成新的符号表。

2.2.1.2 符号表

所有交互都来源于符号表

符号表基本上就是为了交互而生

符号表引用就是为了避免直接引用,因为直接引用引入了代码编程思想,限制了组合的能力,除非组件之间完全独立无交互,只要交互通过直接引用就耦合了类型,符号表这是实现类型解耦的关键

符号表需要是公共资源的形式管理,用户可以下载很多开发者定义和上传的符号表,这些符号表由开发者上传,比较有名的符号表可能会得到很多其他开发者的支持和兼容,从而实现跨开发者之间的协作

多个开发者定义的符号表也可能有重复,需要统一的机制,这可以通过:

- 强化全局表,把开发者定义的符号表发展为全局表

- 全局表分类

- 建立表之间的映射和关联,这比较复杂

所有的类型引用都通过数据查找

但是数据不能完全代表类型

某种程度上,数据的组合才代表类型

ECS的最大问题可能是无法区分类型,只有定义字符串或者枚举数值,tag之类的?这些类型由变量的值而不是符号本身决定,这些值可以有开发者或者用户控制

但是tag需要是针对组件,而不是实体

- 实体可以任意复杂,他不可能具有单一类型

- 类型可能被多种组件访问,内存无法控制

定义多个标签,每个组件都包含自己的标签,或者跨组件之间的数据必须是结构体符号,这样结构体本身就包含了类型

这可能导致数据属性重复的结构体,但这没关系,本身数据就是有不同意义的,即使数据结构差不多

考虑只针对某种类型的怪物的血量造成伤害

这个类型标志应该是跟HP关联在一起,还是跟怪物实体呢?

需要一个万能标签,每个组件一个,但是名字相同,编译器保证重复问题

原子“数据”

一个组件的数据或者数据列表应该是有意义的,这个数据的组合应该充当类型,表示一类功能对应的数据,比如HP和Health 通常是组合的,所以我们就不应该单独使用HP,如果有多种类型都需要使用HP,这就需要定义一个结构体

当然这没问题,符号表的意义并不是全部打散成独立的符号,而是为了避免类型引用,但有一下问题:

- 理论上可以为同一实体添加多个HP,这需要开发者用户来避免

所以类型看起来更多应该是由组件的数据合作隐式定义,而不是由符号表来定义,符号表应该足够松散,这样来保证最大的灵活性

组件定义的TAG变量不来源于符号表,但是和符号表类似的定义,编译器特殊处理

或者TAG数组组件本身,是一个用来取代引用组件类型名称本身的一个标志

2.2.1.3 符号表定义标准

尽管从概念上,符号表表示的是一个变量属性,或者是变量的定义,它的目的看起来就是为解耦变量的声明与引用服务。

但是从系统的需求上看,一个符号表应该是包含一个完整的对某一些事情或某一类逻辑的一个完整数据结构,因此它定义的是一个标准。参见2.7节。

2.2.1.4 版本与兼容性

- 修改名称:可以做一个映射,编译器直接处理,甚至组件可以一键升级,代码替换最新名字

- 删除符号:如果发现缺失相关符号,相关的组件不再被解释/编译仅程序,并提示用户组件过期,需要更新;这部分通知通过Reality World进行管理

- 新增符号:会通知开发者,建议开发者支持

2.2.1.5 符号“定义”变量

在RealityIS中,组件并不真正的定义变量,例如它只能选择变量,但是不能决定变量的类型;此外,它存在着重复定义的问题。

为了解决如2.7.16.5节描述的重复定义变量的问题,组件中的变量定义是一种特殊的机制。整个变量定义和使用的过程如下:

- 符号表唯一定义一个变量,但其实它并没有分配内存,但它决定了变量的类型和结构

- 组件中引用符号表定义的变量,但也不是简单的引用

- 当一个对象第一次遇到某个符号时,它在该对象上添加该变量,并分配内存

- 当后续的组件引用相同的变量时,它始终将地址指向前面分配好的内存地址

见2.7.16.5节的更多描述。

2.2.1.6 符号定义不可分割的最小属性集合

一个符号应该定义一个不可拆分的数据集合。比如:

Position {

float x;

float y;

float z;

}

如果一个以上的属性总是同时出现,那么将它们定义为一个符号。

将多个相关的符号定义在一起,会迫使这些变量总是存储在同一个对象上,避免了函数因为多个参数分布在多个对象上导致的多层嵌套问题。

2.2.1.7 作为通知机制的符号

除了那些处于嵌套函数最底层的函数所消费的属性,这类属性通常不会触发其他的函数执行计算(显示、存储之类的函数除外),大部分属性除了数值本身,还具有通知属性:即告知其他相关组件,我的数值发生了变化,相关组件需要执行计算。

如果一个组件的值没有发生任何变化,根据组件作为纯函数的机制,后续相关组件都不需要执行计算,除了声明.UseDt的动画类组件除外。

如果动画类组件不受通知机制的影响,那么它会一直执行,这种情况下需外外部对象来执行一个类似Enable/Begin和Disable/End之类的操作。这可以通过Spawn来实现,也可以通过类似获取引用来实现控制,后续需要相关分析一下。

如果需要通过值的是否变化作为后续组件计算的依据,这就使得属性值实际上承担了两个功能:

- 后续组件会使用的输入值

- 通知功能

但这两个功能是有歧义的,例如如果一个技能要求扣除的HP是3,所以整个值3同时承担了通知功能和扣除的具体数值的功能,但是如果下一帧该技能继续释放,那么属性值依旧为3,但是此时系统会认为该值没有发生变化,因此通知功能失效。这说明,单一的值不能同时承载两个功能,它们分别需要自己的数值或者标记。

一种解决思路是在每一帧的末尾,把这些数值清零。但是这样做,其他有些属性会受影响,就是那些不是增量值的变量,它们需要始终存储自己的值,实际上只有像技能这种扣除性的增强属性才可以这样做。

另一种思路是要求所有增量型的变量始终执行,让开发者保证结果是正确的,例如下一帧如果该技能没有释放,那么就需要把值置零。但其实这种置零的过程会是后续的组件误以为发生了变化,根据默认行为。

这个问题在传统的开发中不会存在,是因为它们大多使用主动式的调用逻辑,即发起技能的函数会通过某种形式直接能够触发对扣血函数的调用(例如通过一些Manager之类的函数),因此其实它们不会存在一个中间状态的增量值,因为下一次没有技能释放则压根就不会调用这个函数。

另一种思路是通过消息的机制,传统的消息机制是将消息存放到一个队列中,然后响应者从消息列表获取消息并进行处理,当所有响应者都处理完毕时,这条消息就会被删除。

RealityIS的属性通过按依赖顺序执行的机制,使得属性充当了消息的功能。但是这个消息在一帧结束后并没有清除,而是这个值会永久存在,因此带来了上述问题。

像硬件的输入事件,本质上是类似的问题,但是通常系统输入并没有使用消息的机制传递,而是直接编写update函数,这样监听输入事件的脚本会一直执行,开发者需要保证每一帧的计算结果都不会进入不可预期的分支。但是因为处理输入事件的脚本不会很多,所以不会导致太大的问题。但是如果系统大量开发者自定义的逻辑也已这样的方式运行,则可能会有一定的性能损失。

最简单的方法是使用.UseDt(true)使其像输入组件一样应用执行。后续再考虑优化的方法。

2.2.1.8 存档属性

组件之间进行通信会有大量的属性,显然有很多属性是不需要存档的。而平台也无法判断那些属性需要存档,也无法让创作用户在创作的时候去指定那些属性需要存档,存档的功能属性本身是开发者和标准制定者可以决定的。所以,存档属性应该由符号表来定义。

不管是共享符号表或私有符号表都可以定义符号是否需要存档。

即使是全局共享符号表,有些仅是用来实现不同用户之间交换的符号是不需要存档的。例如那些仅仅是无关紧要的通知属性。

比如玩家在攻打一个Boss,这其中需要花费大量的精力,通常几分钟甚至十几分钟,这期间Boss会有很多状态变化,玩家的动作、动画状态、行为树等等也会发生很多变化、环境中的树木也可能临时被炸掉等等。但其中除了用户使用的技能道具等,其他大部分数据都不要存档。

Boss战存储的更多是一个大的结果,这样当其中出现崩溃时,玩家可以重新打Boss。

对于存档属性,运行时会保证当组件正常执行后,其修改的结果会被存档。

2.2.2 Entity

ID + TAG

每个实体有个隐藏private变量:TAG和TARGET用来定义组件本身的标识符,以及用作查询条件的标志符

在Entity上增加TAG,因此充当一个Entity的类型区分,创作者可以在Creation中创建一个Layer表对其进行管理,例如可以统一命名等。

对于System的TARGET,它指向Entity的TAG属性,虽然System对于一个Creation只有一个实例,但是System本身只包含方法,System的状态数据(private私有变量)是存储在每个Entity内部的,它具有多个实例。因此对于TARGET来说,每个Entity的值都不一样,因此Entity可以处理不同的类型目标Entity。

2.2.3 三种变量类型

#version 1.0

#order 5

namespace SomeComponent{

query Global.HP as hp

query Global.HP[] as hps

public Global.HP as hp

private fTemp = 100.

private TARGET = 20

}

三种类型变量说明:

- private 是每个组件的私有变量,只有该组件内部可以访问,这可以通过直接声明实现,因为没有从全局符号表引用声明,所以其他组件没有可能对其进行访问;private是实体的实例变量

- public 是每个组件的公共变量,可以被实体内跨组件访问,也可以被其他实体访问;public也是实体的实例变量;通常public变量由使用该变量的组件定义,可以多个组件中都重复定义,会被映射为同一个变量

- query不是组件本身的变量,它是指向外部变量的引用,它只能访问那些定义为public的实体

2.2.3.1 私有变量

私有变量只是实体内组件才可以访问的属性,实体是用户创建的,其所有权是属于用户的,同样,该实体所有的组件是由用户选择的,所以这个选择间接包含用户对该组件访问该实体数据的权限。

选择组件:

- 除了是一种功能构建行为

- 也是一种授权行为

组件能够访问自己所在实体的任何属性,不支持在实体内再划分权限,那么将会增加复杂度,而且看起来没有那种必要,实体这个粒度作为权限单位:

- 即是足够的,合理的

- 也是用户设置和管理起来相对比较容易的

2.2.3.2 写入权限

组件只有对自身实体所在的属性才具有写的权限,不能对其他实体数据进行修改,否则权限不可控制,因为权限是按照实体为单位进行构造的。

这也是一种拉取模式,参见2.2.11.2节。

2.2.3.3 私有变量不是组件的状态

一个实体的属性,要么作为组件的输入,要么作为组件的输出,它总是对一个实体的每个组件可见的。

但是像类似动画或者一些自定义跨帧逻辑的这种组件,他可能需要存储一些跨帧的状态,这个可以通过私有的符号表来定义,但它们跟其他属性之间存在一个主要区别:

- 这些变量一般只能被一个唯一的组件感知,其他组件不应该也不需要知道它的存在

但如果只这样,就造成一种潜在的问题,这些变量看起来充当了这些组件的状态:因为输入条件不变的情况下,可能有不同的输出,这破坏了组件充当纯函数的目标,也使得通过输入是否变更来决定是否需要执行组件计算变得困难,参见2.3.3节。

针对这种情况,一种解决方案:

- 让这些中间变量成为时间的函数,在每一次函数计算中,由组件函数根据dt参数计算而得

这种可能会每帧重复计算一些内容,但是其实可能问题不大,因为那些存储的中间状态,其实大部分是每帧都要代入dt进行重新计算的。

尽管这可能带来一定的性能损失,但是相对带来架构的简洁性,是可取的。例如在传统的函数式编程当中,为了维持函数的纯函数特性,以及变量的不可修改特性,其实也做了大量复制相关的操作,但是相对性能,它们带来的架构价值更大。何况RealityIS可以通过分布式及其他特性来弥补这些性能损失。

2.2.4 数据抽象:共享变量与解耦

变量的声明与程序执行指令的耦合,是现代计算架构最大的限制,这可能有2种原因:

- 现代编程语言主要是还是基于硬件计算架构的,它上面所做的抽象,更多是围绕用开发者(人的)的角度怎么去理解和组织机器代码的结构,而没有围绕人类理解事物真正的逻辑去进行调整。

- 现代的应用程序架构都是围绕单个独立的应用程序设计,即使有多个应用程序之间需要交互的需求,这些少量且相对比较固定的需求可以使用一些标准的形式解决,例如HTTP协议。

在未来的元宇宙时代,我们需要一些全新的编程架构,所以最重要的是:

- 我们需要在硬件架构和应用架构之间,建立起一个数据抽象架构,将传统硬件计算架构的限制隐藏起来,并且上层应用架构的能力可以更大的释放。

所以,RealityIS的核心逻辑,是通过对编译过程的改造,在操作系统和应用程序之间建立一个新的转换层,是能够将基于数据抽象的程序架构,转换为传统基于硬件架构的程序结构。

2.2.4.1 共享变量的声明

#version 1.0.0

#order 1000

namespace SomeComponent{

public Global.iHP as iHP = 5

public Global.vfPosition = (1000.0, 234.5, 400.8)

public Global.sLabelName = "Super Man"

private fTemp = 500.6

fn Update(fTime){

fTemp = fTemp * fTime

iHP = fTemp

}

}

由于每个组件定义变量的顺序可能不一样,所以编译器要进行排序。

此外,由于这里使用全局符号名与局部简写名字的区别,在解释器中,需要去除本地变量名称,使用统一的全局名称,因为不同组件对于同一个全局变量,可能使用不同的局部变量简写。

对于需要处理其他物体的组件,定义一个数组的形式,解释器自动查找:

#version 1.0.0

#order 1000

namespace HandleOtherComponent{

outer Global.iHP[]

outer Global.vPosition[]

out vPosition as position

fn Upadte{

for i in iHP{

if(distance(vPosition[i]-position)<10){

iHP[i]-=1

vPosition[i]=(10,10,10)

}

}

}

}

上述的类型用于由一些特定对象发起的行为,如果是全局组件,全局组件每个场景只有一个Entity可以拥有

#version 1.0.0

#order 10

namespace PhysicalComponent{

unique Global.Collider[] clliders

}

定义了global的属性解释器会解释唯一性,这也意味着有些组件是没有方法的,但没关系,从用户角度来说它仍然是一个功能,例如:

#version 1.0.0

#order 100

namespace ClidderComponent{

public Global.Cllider

public TAG = 100

}

也就是组件分为三类:

- 一类对自身进行处理

- 一类对其他对象进行修改,这种情况有一个发起的对象

- 一类是没有特定发起的对象,它是对于某些类型的通用行为,例如物理引擎

2.2.4.2 共享变量的初始化

生产者和消费者都可以设置初始值,其中一个修改会复写另一个,因为对于共享变量,一个实体只有一份数据。

初始化的方式:

- 编辑器中修改,每次选择一个组件,设置后,下次其他组件加载的也是修改后的值。

- 在运行时,用户选择一个物体,对其进行修改,运行态用户只看得见一份共享变量,组件只有私有变量可以单独设置。

- 通过代码的形式加载组件,按时间覆写数值。但一般情况下,组件的初始值应该由其定义默认设置,否则容易造成迷惑。一旦实例运行一段时间之后,值应该由持久化的数据进行加载初始化。

2.2.4.3 函数参数解耦

- 每个组件只需要对感兴趣的数据进行交互

- 游戏特有的Update机制保证两个对同样数据感兴趣的数据都能够按顺序被执行

剩下只要我们保证两个组件之间的逻辑顺序,它们之间就可以以间接的方式实现交互。在这个过程中,共同感兴趣的参数充当了函数参数,同时不需要引用其他组件进行调用。

这是一种全新的机制,只有这样,才能实现两个独立组件之间的交互,而且,除了对函数调用进行解耦,它还有一下三个好处:

- 每个组件只需要处理自己感兴趣的数据,不需要去关心跟其他组件之间的交互,例如就不会出现面向对象编程中常见的你调我还是我调用你的问题,这让我们将编程思想回归到本质,每个函数都只是处理自己感兴趣的数据,并输出相关的数据,但这个函数式编程还不太一样。现实生活中,大部分功能都是在处理数据,这种思维理解起来更简洁。

- 简化并发相关的问题,大部分并发相关的问题都是由于面向对象编程中的对象相互调用导致的。不仅不利于并行计算,而且容易导致各种并发问题,例如死锁,资源抢占等等,因为不可预期的多个对象会访问同一个对象。

- 还能减少因为变化导致的重构、重新发布程序等问题。当一个函数参数发生变化时,必须要修改调用者的代码,它可能使得其他组件不再可用或者崩溃,因而使得其他组件不太愿意更新到最新引用,从而导致系统进化很慢。函数解耦可以使得一个组件的修改至少并不会影响程序的运行。当然如果逻辑发生了较大的变化,程序的计算结果可能逻辑上是不及预期的。这种要有好的机制保证及时更新,但这种机制是系统更上一层的机制,在系统层,我们首先应该保证平台运行的稳定性。

2.2.4.4 赋值与解耦

传统的赋值语句本身就包含了耦合,它由一个读取语句和一个写入语句构成,虽然从逻辑上来讲没问题,其中包含安全问题

- 读取语句引入耦合,原本我只想给资源增加一定的增加,我并不需要关心总量

- 写入是重写,覆写操作,具有破坏性

尽管程序中有+=操作,但是由于它与写操作是同一权限,能够执行+=操作的变量意味着可以执行写操作,因此仍然具有破坏性

需要将原值读取出来,进行一定的计算,例如加减计算,然后进行赋值,这使得原本对值进行增量的操作逻辑,很容易写到实体外部,即增量来源的地方,这种操作引入了不必要的耦合,因为增量实体根本不需要包含这样的逻辑,但是如果要隔离权限,开发者必须得写一个类似Add(delta)的方法

Machinations 的资源流的一个重要基础,它将两个实体之间的联系,即经济的流动,都看成是增量的,这样经济之间的流动过程中,各个实体就只需要关心自己的事情,然后输入输出一个增量就可以,这个增量本身对两个实体没有任何耦合

生活中大部分其实就是这样的流程,想象一下,你要取100元钱,银行直接给你100,而不是你让银行先把所有钱给你,你拿掉100,再把剩下的钱存回去,如果你在数钱的时候被旁边的人抢走了怎么办呢?

Creation Script 中,组件之间(即对外部变量)的修改支持:

- 增量式修改

- 并且一个组件之间多个修改保证原子性

这使得每个组件只专注于构造自己的增量,大大见减少耦合,并且不需要编写复杂的方法来实现增量修改

如果实在是需要依赖于总量进行计算的,这种少数情况可以先读取总量,计算合适的增量,再对其进行修改

默认增量与默认赋值相比,虽然能实现的功能都没有差异,但是它避免了大部分情况下的耦合,毕竟大部分操作是增量,而且在ECS中在Component 中不适合写方法

编译器也可以进行优化,系统生成更优化的代码,当然这个功能本身不是为代码优化服务的,它是为用户开发效率服务的,能够简化逻辑关系,让用户逻辑更清晰。

2.2.5 组件语义化

符号表机制带来的最大价值,是它消除了模块之间的显示调用参数传递,使得一个组件退化为一个功能,而隐藏了传统编程中要使功能运行起来的参数传递,因为这就需要变量的声明和初始化,而变量的定义有涉及类型系统。这就不可避免导致对编程的学习。

当组件抽象为一个功能,它就可以语义化,一个功能用一个语义表示,而语义是所有人可以理解的。一旦用户选择一个语义,对应的功能及其跟其他功能之间的交互就会自动适配和工作,用户最多需要设置一些特定的属性值。

2.2.5.1 语义化与可视化

符号表及其游戏Update机制,联合起来解决了两个函数之间参数隐式传递的问题,使得不需要开发者或者用户显式指定两个模块之间的参数,既简化了逻辑开发,又使得函数或者代码功能的语义化成为可能

语义化以后的程序,形成可以用自然语言描述的结构,有了这个基础,再结合自然语言人工智能和语音方面的进展,可以做到最简化的内容创作

- 自然语言

- 结构化语言

这是两种完全不同的机制,虽然自然语言中本身也是有句子语法结构的,但是自然语言本身并没有编程语言那么高度结构化,例如即使包含语法错误,人与人之间的交流也可能因为相同的经历、知识等原因对其进行纠错,从而忽略错误的语法,然而机器执行的结构化语言也不同,除非是基于AI进行学习,但是那样又需要大量的数据学习

可视化图通常由一些:

- 节点和

- 节点之间的连接关系

来表示,节点表示一个流程的功能,而连接关系不仅表示了某种流程顺序,他还表示了流程之间需要遵循的参数约定

既然符号表解决了参数传递,那么剩下只需要显式声明节点的功能定义,则整个图可以构成结构化的描述,同时也是可视化的

由于自然语言不具备精确定义,所以需要定义明确的节点结构

这种结构最好是一种描述语言,他具有基础的语法结构,而基于这些结构进行扩展可以构建具体、复杂的实例

所谓语言结构,即包括它的参数(连接属性),它的功能属性都是明确的

相反,只是任意定义一些没有联系的基类,则无助于构建有价值的可视化图,因为尽管他可以连接一些节点构成图,但是这个图的流程和意义是完全没有意义的,没有价值的

2.2.5.2 能否自动生成Machinations

Machinations 提供了这样一个基础,他能构建起易于理解具有一定逻辑的可视化图,但是它的结构是以经济流动为基础的,有些逻辑不一定有明显的经济因素,所以可以对其进行扩展,有了这样严谨的语言结构,再把组件定义为这样的逻辑单元节点,则节点的语义就明确而且又意义了。

这样可以方便用户涉及Gameplay的玩法

对于每个Machinations中的元素,设计对应的Component,只要从这些Component集成的组件,就自动遵循相应的功能或者接口需求,就可以自动生成设计的可视化图。

或者甚至可以根据Machinations反向生成初始代码。

或者甚至如果Machinations是一种通用编程语言,所有的组件就要求开发者这样去做,这对于用户来讲,就更好控制逻辑行为。

可以对Machinations进行深入分析,加一定的改造。

2.2.5.3 复杂系统的仿真

复杂系统的仿真,对现代工业很多研究直观重要,并且由于真实世界中大部分深刻都机制都深藏于复杂系统中,往往那些直观简单的结构化机制并不足以洞悉这些系统的原理和影响,所以我们需要更好的程序机制来支持复杂系统的仿真。

然后由于复杂系统的特征,现在计算架构并不能很好的处理这类任务,例如:

- 复杂系统往往非常庞大,使用传统面向对象的机制通常无法维护这么庞大的系统交互关系,很难建模

- 复杂系统一般都是实时系统,它并不太适用于传统的应用程序架构,所以现在大部分仿真任务都是使用游戏引擎来执行

- 复杂系统往往还包含人的交互影响,是一个交互式系统

所以目前并没有很好的解决复杂问题仿真的程序机制或者系统软件,RealityIS有机会在这方面提供更好的基础架构和能力。

2.2.6 组件查询

To read or write data, you must first find the data you want to change.

The main way of processing DOTS data is ECS queries. Iterating over all entities that have a matching set of components, is at the center of the ECS architecture.

To identify which entities a system should process, use an EntityQuery. An entity query searches the existing archetypes for those that have the components that match your requirements. You can specify the following component requirements with a query:

var queryDescription = new EntityQueryDesc

{

None = new ComponentType[] { typeof(Frozen) },

All = new ComponentType[]{ typeof(RotationQuaternion),

ComponentType.ReadOnly<RotationSpeed>() }

};

EntityQuery query = GetEntityQuery(queryDescription);

按类型查询组件对用户来讲不太好理解,它让你必须很清楚所有实体中哪些实体具有哪些组件的组合

按类型查找也限制了组件的行为,它只跟类型一致,而实际上,一个攻击可能只针对某些类型的怪物,这些怪物的数据属性是相同的,即可以使用相同的组件,但是因为值的区间不同,它们被分为不同的类别,除非你重复定义Component,这些Component有相同的属性,否则你无法区分它们,即Component充当了类型,但是实际上它只是数据,不能完全充当类型。

怎么对于DOTS中的查询,由于符号表的意义是取代类型引用的,所以ECS中Component的类型需要放到符号表中,换句话说,符号表中的名称同时也表示了符号,因此符号表需要是结构体,像shader中的变量一样,这个结构体的名称或者这个结构体本身就代表了组件类型:

例如符号:

struct Position{

float x

float y

float z

}

组件中的定义:

#version 1.0

#order 1

namespace SomeComponent : Component{

public Global.Position as position

fn update(float dt){

}

}

外部引用的组件,使用query修饰符,表示这个变量不是该对象自身的变量,而是查询结果,如果有多重查询,需要定义一种联合查询的方式,但是可以先仅考虑但组件查询,Unity间接使用了多种组件的某些特定组合数据来定义一个System,因为单个组件无法确定数据类型

#version 1.0

#order 2

namespace AttackComponent:Component{

query Global.Position[] as positions

query Global.HP[] as hps

public Global.HP as hp

public Global.Position position

fn update(float dt){

if input == 'B' {

for i in positions{

if(distance(position-positions)<10){

positions[i].x -= hp

}

}

}

}

}

2.2.6.1 组件组合不是理想的查询方法

在Unity DOTS中,按组件组合查询有两个好处:

- 最大的好处是直接获取数据,因为System需要操作这些数据,所以直接声明这些类型就不会出错

- 然后才是在这个基础上,将组合定义为一种特定的逻辑类型

目前看起来形成这套机制的核心原因是因为前者;但是这种组合本质上不是真正的查询条件,他可能导致一些意想不到的结果。

因为一个Component能被多个System使用,就说明Component本身可以具备多个意义,例如两个不同的System有可能完全按照相反的逻辑去处理,在这种情况下,用户定义一个Component有可能刚好不是某个System期望的方式,然而最终它还是被当作了查询条件。w

2.2.6.2 显式声明

还是需要某种显式声明的类型,哪怕是Layer这样

感兴趣的数据+TAG数组(多个TAG感兴趣)

只需要声明自己感兴趣的数据就行

由于数据无法表达类型,有用户手动设定

可以像Unity一样定义一个Layer列表,方便用户对对象进行归类

Unity的Component 组合查询反而不好理解,太复杂,需要记忆更复杂的东西,相比Tag,tag概念足够简单

- 只要能任意查询,就可以满足通用性

- 符号表满足任意组件间通信

- 组件语义化

2.2.6.3 RUST ECS

You can use empty structs to help you identify specific entities. These are known as "marker components". Useful with query filters.

/// Add this to all menu ui entities to help identify them

#[derive(Component)]

struct MainMenuUI;

/// Marker for hostile game units

#[derive(Component)]

struct Enemy;

/// This will be used to identify the main player entity

#[derive(Component)]

struct Player;

2.2.6.4 Labels/Layers

2.2.7 Component + System

Unity将Component和System区分开,主要是为了将代码和数据分开,使得System中不包含任何数据;即System本身也不能有任何实例数据,因为那样相对于它需要处理的Component而言,其中存在了“全局变量”,这引入了实体间的相关性,耦合,并使得很难定义每个Component之间的状态。

但这也带来了不好的后果:

- 使用者需要分别单独添加Component和System

- 并且使用者必须很小心处理它们之间的关系,比如你定义了Component,但是如果你的系统没有添加相应的System,则数据可能没有用处,这些实体没有任何行为定义;反之,如果引入了System,但是场景中根本就没有对应Component对应的实体,则这些System也无法发挥作用。

Creation同时解决了上述两个问题,方法是将两者融为一体,但是通过编译器将属性抽取为Component(当然Unity也存在类似的转换机制);更进一步,Creation通过public、private和query标志符区分了公共变量、私有变量和引用变量,使逻辑更清晰。

除此之外,Creation和Unity在功能层面是一致的。

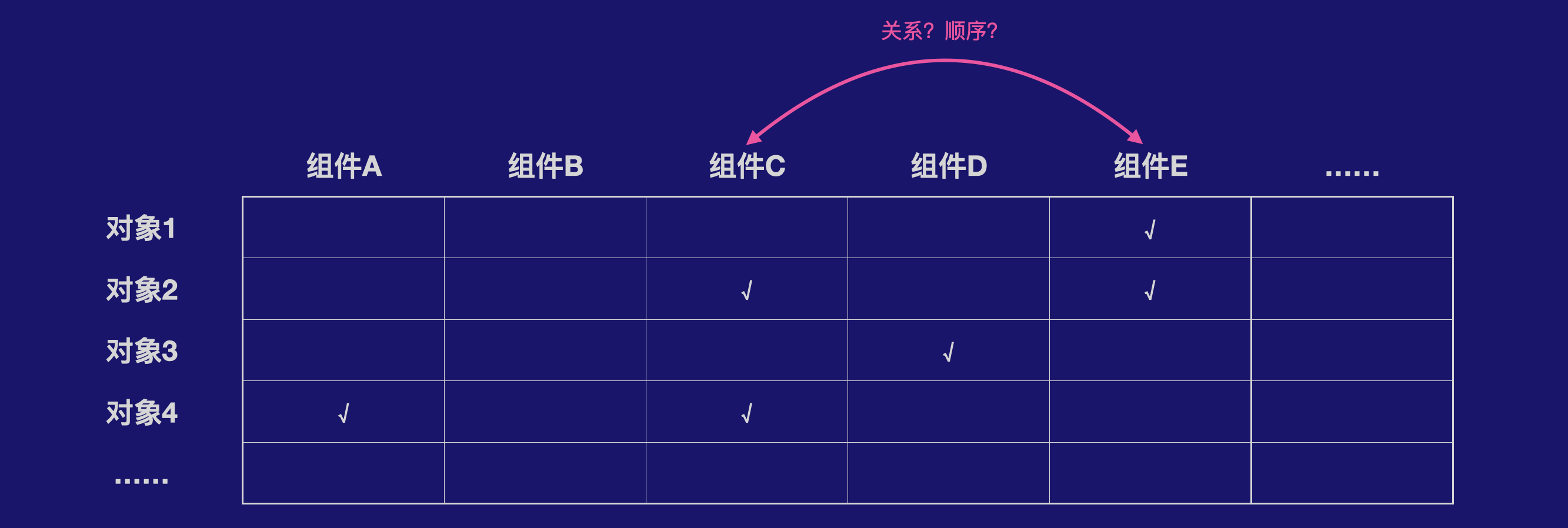

2.2.7.1 组件执行顺序

由于多个未知的程序可以对实体执行操作,所有很难保证顺序的正确性,这比Unity DOTS要复杂,后者由单个开发者开发所有组件,能够严格保证逻辑顺序。但是RealityIS中,同一个实体可能包含来自不同开发者定义的顺序,可能会完全冲突的。

如果允许用户自行去调整执行顺序,会一下子对用户提高了很多要求。

但是我们仔细去分析一下一般的情况,如果能够在做一下假设或者约束,那么问题就会简化很多:

- 1,所有对属性只读的组件都放在最后执行,所有对变量只读的组件之间不用关心任何顺序

- 2,所有对属性可写入或者只读的组件之间都顺序无关

或者更进一步,我们假设:

- 3,每个组件只有一个可写入属性

这样整个问题就可以非常简单地被处理,虚拟机动态调整组件的执行顺序,并且不需要用户或者开发者在关心任何顺序相关的事情。

现实中,这三个条件还是比较容易满足。其中对于第3条,这就有点像函数式编程,每个组件是一个 函数,该函数只有一个输出值,并且所有输入参数都是只读的。如果每个组件只有一个可写入的属性,那么就很容易区分出所有只读和可写入两大类组件。即是说,第三个假设可以把所有组件分为两类:只读的组件和只写的组件。

然而即便如此,还是剩下两个问题:

- A和B组件对两个属性交叉读写

- 只读或者只写属性之间由依赖关系

对于第一个问题,在对组件进行自动排序时,将无法推算实际的计算顺序。有两种处理方法:

- 一种是遇到冲突时交由用户来指定,但是由于组件的顺序是全局的,而不是根据用户设置来的,例如两个用户可能设置了相反的顺序,所以这种方法不可取,并且它需要用户介入。

- 第二种方法是由开发者来解决冲突

首先,开发者是最了解逻辑的,而且开发者一旦解决好冲突就不需要用户在做不必要并且增加复杂度的设置。可以把所有代码看成一个整个,当开发者在提交代码的时候,并不只是要考虑自己的代码冲突,还要考虑全局代码冲突。两个开发者提交代码总是有时间先后顺序,所以可以对于后提交代码的人,系统抛出所有可能与之冲突的组件。有开发者通过了解冲突组件的功能,并比较自己组件的功能,来设置依赖关系。

当然这种方式也不是完全可靠,例如开发者可以根本没有看对方组件的功能,随便设置了一个顺序,这时候可能导致错误逻辑。一种可能的方法是,对这些有冲突的组件,后面开发者的设置 结果会发送给前面开发者,前面开发者可以对执行顺序提出异议或者同意。

对于上述第二个问题,分三个层面:

- 开发者尽量避免编写这种在一帧之内有复杂依赖的组件,比如如果组件之前都完全没有依赖,那就不会存在这个问题

- 另一方面,具有这种复杂顺序的组件,通常对应的是一个开发者内部的逻辑,这时候它自己设置正确的顺序就好

- 对于组件之间的这种可能性,大多数情况下没有意义,可以不用理会,由用户自行发现问题后反馈给开发者协商处理

2.2.7.2 Change-driven update

事件表的意义:

- 通过建立事件队列,延迟到一起执行,消除一定程度的并发,同时能够做到并行计算,因为一些相同类型的事件可能对应相同的组件,即使同一个事件对应不同的组件,通过按组件类型排序和组织,也能学到按顺序并行;

- 将一部分由状态变化导致的分支转化为事件序列,当然实际处理机制可能不一样

数据库重组涉及更新符号表、以及Table的数据重新调整,符号表和Table API一样,需要符号表API

2.2.7.3 ECS

Unity中ECS的system 只有一个实例,它跟Component 之间的联系由System 对Entity的Query定义,但是带来的结果是系统初始化的时候需要独立完成两个操作:

- 设置每个Entity的Component

- 实例化所有系统会使用的System

这种弱关系的一个可能的结果是有些System 可能查询不到任何具有感兴趣的Component ,而且系统没法自动计算,只能由开发者手动加载

此外,这种System 对Component 类型的确定性引用,使得程序很难动态构建新的场景

而且关键是普通用户很难去理解上述两个操作之间的关系,例如:

- 如果用户给一个Entity 添加了某个Component ,但是他很难比较明确地要去再添加哪些System ,这可能需要类似于给一个对应表,而这种对应关系可能有很多

- 如果用户按照System 的功能描述添加了某个System ,他又可能忘了要给一些Entity 添加对应的Component ,程序没办法检查这种情况

- 此外,更严重的,System 的定义和开发必须了解Component 的定义,这就回到以前的问题:Component 需要协议,这很复杂

实际上System 和Component 是严格相关的,他们分开没有意义,在OOP中它们就是定义在一起的,在一起可以避免需要做两个独立看起来不相关的操作,但实际上是相关的

所以还是需要和在一起,使用全局符号表,但这带来一个新的理解上的问题:

System 全局应该只有一个实例,但是随着Component 一起加到一个对象,使得看起来每个Entity 对会执行这个方法

但这问题是否也不大:

- 对于内部组件,他本来也是需要每个对象执行一次,在ECS中只是我们强调并行,其中一份代码对多个数据执行,而隐藏了System 其实对每个实体执行的感觉,但是在内部其实是循环,所以本质上是那个实体都要执行

- 对于特定实体遍历其他实体,他其实也是那个实体都会执行,比如一个塔防游戏,那个炮塔都要遍历行走的怪物,看看是否在范围内,如果在范围内就对其造成伤害

- 对于全局的,那就更好理解,解释器保证全局只有一个,那么就是该实体执行了一次

到这里主要的问题在于,对多个实体的遍历往往带有一个条件形成分支,并且那个并行的组件A内部都在单独访问所有实体,又可能造成:

- 并发冲突,多个线程同时访问同一实体

- 内存局部性破坏,每个组件分别访问不同的数据

针对上述问题,解释器要把第二种情况的执行转换为一个一个组件A顺序执行,在每个顺序执行的组件内对感兴趣的数组进行并发计算

或者更好的方案,对所有感兴趣的实体数组,并发地安顺执行组件A对应的实例

这就是解释器的好处

当然,对于第二种情况,由于System 看起来可能被构造多个实例,所以需要解释器只构造一个实例,并记住哪些组件引用了这个实例,也就是在Unity中为了支持Entity的Query,他也需要实现一个数据库来记录这些引用关系,即使针对第一种和第三种组件也是一样的

2.2.7.4 ECS参数

基于Component 组合的方式改变了传统编程模型中的参数传递机制,传统的编程模型都需要参数传递,不管是:

- 通用编程语言

- 可视化编程语言

- 声明式编程

- HOUDINI 程序化编程

一个System 处理数据,这些数据可以分为:

- 内部定义数据,在对应的Component 中,内部定义通常用来保存帧与帧之间的内部状态

- 外部引用数据,定义一个全局较大的公共属性名称,每个名称有特定含义,仅有引用的名称才会动态组合成所有的数据,这些机制靠编译器来处理,全局属性表之间可能有依赖,编译器自动引入;如果一个插件开发者或者Creation开发者编写的组件需要跨系统引用,需要定义私有名称列表

Global Name

Private Name

这样一来,Table Engine 所做的大部分操作就是进行数组的生成、初始化、复制、排序、修改、SOA等,这部分通过原生的高效实现,通常Table是动态生成的,不知道维度和长度等信息,这就是Table要做的事情

Global Name中的每个属性名称都是具有语义的,相当于宾语,而每个System引用的Name都可以追踪,因此可以归纳出System大致的语义结构:

在什么条件下做什么事情,条件通常是Global Name中某个属性的值

条件 主语 谓语动词 宾语

如果$NAME<5 System 由System开发者填写,可以多个 Global Name

数据很少是只有一个System 单独消费,通常是多个System 会共享一些component 数据,例如物理引擎组件、动画系统或其他组件会修改位置,而渲染组件会使用这个组件进行渲染

一种常用的模式是:

- 一个或多个组件对某个数据进行修改,通常表现为读写

- 通常一个或者少数几个组件对数据进行消费,通常表现为只读,并且使用目的通常是为了给用户反馈,或者写入到系统或者进行数据存档

由于多个组件会访问数据,因此为了避免数据重复定义,有必要定义一个比较大的标准数据和对应属性名称:

- 其他系统通过引用使用

- 每个系统仅使用部分数据属性,通过显示声明引用

2.2.7.5 组件之间的通信

两种机制:

- 事件,参见2.2.7.2节,本质上是状态处理

- 直接调用,就是正常方法

2.2.7.6 单例组件

有一类组件,只可以添加到Root对象上,它不可以被添加到任何自定义实体对象上。这可以用来处理一些特殊情况。

2.2.8 消息通信

用户间通信的情况或类型有几下几种:

- 读取和感知,这是最基本权限,让别人可以了解一些你的属性,状态 ,甚至性格,以及可以怎样与你进行交互

- 交易,所有用户之间的涉及修改的操作都是一种交易,你必须消耗某种类型的资源,另一方获得某种类型的资源

暂时不开放那种会对其他人造成破坏性的功能,例如攻击别人,也就是Reality World没有暴力,没有坏人,没有破坏。

但你可能会因为经验不善而破产,例如地皮是需要租金的,因此你必须赚钱,否则你就没有收入。

当然最好的机制是你的创造力越强,付出的时间越多,收入越高,相比传统的模拟经营游戏主要 依赖于时间,这里我们更强调创造力,其实也是现实世界的能力。

2.2.8.1 系统机制

但现实世界有一些全局行为,例如天气对全体城市人员的 影响 ,例如政府的政策等,这些后续再考虑。早期是一个单纯的交易系统。

组件之间的消息通信大概可以分为两种:

- 基于ID:在组件内保存组件ID,然后直接发送只特定的一个或多个ID,就像Erlang中那样

- 基于类型:使用类型+UserID进行判断

前者的机制其实类似面向对象编程中的机制:首先你需要取得另一个对象的引用,然后你就可以向其发送消息(调用函数),当然Erlang使用Pid耦合度更低 一些。但耦合仍然是存在的,例如对方函数签名修改了,或者甚至删除不存在了,或者PID被修改了,都是可能引起问题的,程序开发者需要去小心地维护这种关系和结构。

RealityIS采用的是基于类型的机制。

基于类型的机制相对于基于ID的机制会引入一个新的问题,即 N:N的关系,基于ID的机制本质上是1:1的关系,其1:N的关系也是按顺序一个一个发送的,这些发送消息本身也是按顺序串行的。

首先介绍两种常见机制:

- Unity机制:Unity的System并不是单个组件的计算,它本质上要求开发者维护集合操作结构,那么对于N:N的问题,开发者自己编写两个嵌套的循环结构就可以了,但问题是每一个System都需要编写这种循环控制结构

- Erlang机制:尽管Erlang的发送消息是1:1的,但是接受消息确是N:1的,Erlang的机制是对每个进程使用一个邮箱存储一个消息列表,但是开发者并不需要感知到这个消息列表,开发者编写的还是对单个消息的处理,但要求开发者主动编写一个获取消息的操作,然后每个receive的操作就会被分配一个消息,直至邮箱中的所有消息被处理完毕

显然Erlang的机制对开发者更友好一些,但对于消息的发送方面,由于基于类型的过滤,一个组件间接多同时向多个组件发送消息,而不是像Erlang一样让开发者维护一个PID列表逐个逐个发送,因此需要运行时将这个发送的过程形成一次列表操作,来实现Unity机制中的外部循环,这样组件就可以避免引入列表操作的概念,而专注于逻辑。

在RealityIS中:

- 发送消息的逻辑是通过读取组件属性来实现的

- 处理消息的逻辑则是通过写入属性来实现的

这样就要求读取的组件属性不能超过1个,否则同时处理多个组件的消息就变得不可能,除非这多个属性同时来自于同一个实体。这也是一种过滤的条件,但是开发者可能不一定容易理解。

- 跨实体要求只读取一个属性

- 同一实体可以读取多个属性

不管怎样,发送者和接受者只能是一个实体。读取的所有属性组合构成发送者的过滤条件,而写入的属性组合构成接受者的过滤条件。剩下的问题就是Unity 也面临的问题,即单纯依靠类型过滤是不够的,需要另一个层次的过滤条件,就是用户添加的Type,但是组件开发者不需要考虑这个事情,因为这种特定的事情是由业务逻辑决定的。如果有定义,接受者和发送者必须手持相同的CID,并且只要其中一个拥有CID,它们就不能与所有不具备相同CID的组件进行通信,进一步,这种CID可以转化为公钥和私钥,避免被相同的CID进行通信,例如攻击者会尝试与所有CID进行通信,事实上他应该是默认方式。

2.2.8.2 组件安全

不能对其他人的Creation或者实体进行删除或者修改,理论上,对其他人的数据只能读取,所有的修改操作均是交易

- 私有

- 好友之间

- 所有用户(包括陌生人)

2.2.8.3 权限控制

每个公共属性,一般来讲,应该只有一个核心定义,其他的均是对它的引用,就像传统的编程语言中,对象只声明一次,因此它的权限也在这里被定义。

在Creation Script中,由于变量直接变成符号表,因此定义的概念被模糊,符号表之后的引用正确被保证,但是符号表的来源确实不清晰的,因此无法控制变量只能在一个地方被定义。甚至没法区分是谁“定义了”变量。比如,如果两个组件同时定义了一个属性,但分别使用了不同的权限控制,则可能产生歧义:

namespace ComponentA {

public readonly Global.HP as hp

}

namespace ComponentB {

public readwrite Global.HP as hp

}

当上述两个组件被添加到同一个实体了,权限将发生歧义。

实际上,这里由代码开发者来定义权限是不合适的,在传统的游戏开发中,为什么开发者可以定义权限,是因为开发者即是应用的拥有者,或者说开发者是按照拥有所属者的旨意或意愿进行设置的,所以不管怎样,开发者和应用Owner是同一人。

随着UGC或用户创作平台的兴起,这种身份的统一性发生了变化:开发者和应用Owner可能是独立不同的人,在这种情况下权限完全由开发者指定是不合适的。

但是,另外一些纯计算的数据属性,只有代码内部才会用到,并且用户不会关心,这些数据显然是应该由开发者控制的,而传统的编程语言中并没有区分这两种变量的权限:逻辑变量和公共变量或者用户变量。尽管开发者可以定义public和private权限,但是这种定义仍然有两个问题:

- 首先它的职责就不是为了区分用户控制与开发中间的区别,因此开发者往往不会有这样的意识

- 开发者定义的权限和用户Owner需求之间可能是有冲突的,因为开发者把权限设定之后就不能更改了,而实际上用户权限是可以发生修改的

- 两者之间的定义没有很强的约束性,例如理论上开发者将所有属性都定义为public都是可以的,而Creation Script保证public属性必须来源于符号表,这就是使得开发者会小心地区分。

Creation Script完美的区分了这两者的定义,并且可以实现用户的控制。

实际生活中,我们所属的东西是资产拥有者可以随便修改的,例如一个图书馆,用户可以设置它是否可以被访问,可以开启和关闭。传统的做法是把这些属性映射到一个数据表,然后由另一个程序去读取并修改这个数据表。这个流程非常复杂,增加了程序的复杂性,而Creation Script相当于是直接“修改程序”。

直接控制数据,甚至直接控制代码,是我们这个世界本来的形式。

2.2.8.4 时序性

见2.3.6.1节。

传统的分布式系统大多是响应式、异步的,它们单纯是通过消息传递来解耦进程之间的关系,但是同一个消息可能对应着多个响应者,这些响应者之间本身也可能存在依赖关系,因此这些复杂的关系不太容易梳理清楚,因此传统的分布式系统都默认不处理这种顺序,开发者需要自己小心地处理顺序。

然而实际上函数本身就是包含时序性信息的,例如你需要使用某个变量的值,这个变量的值的赋值语句必须限于使用这个变量的方法调用,而这个赋值语句很有可能就是另一个函数调用,那么就可以得出之前的函数调用顺序应该先于后面的函数调用。

当然上述的理论,这里有个巨大的缺陷,函数本身是一个与变量无关的方法,例如我在方法A之前调用了方法B,然后再在方法A之后也调用了方法B,那么A和B之间的顺序实际上是无法通过函数本身推导而出的。

但是如果我们首先确定了变量,并且这些变量在整个程序运行过程中的名字是不变的,所有函数要么以这些变量作为输入,要么作为输出,那么我们是有可能推导出函数之间的关系的。这种关系是基于变量的,而不是函数的,函数确定相关性,但是计算的是针对一个变量,它所关联的函数的顺序。

但通常这样就足够了,毕竟我们要保证的也只是变量的共享和并发问题,而不是要严格保证所有代码(方法)的执行顺序。

2.2.8.5 性能问题

最简单的分布式系统是传递消息,通常是以字符串的形式,这样的机制使得每次函数调用都需要对字符串进行编码和解码。

Erlang使用的信息通信,传输的是原生的Erlang对象,这些对象被封装成闭包的形式,整个上下文都被保存在一个内存中,其中的变量、函数、及其各自对象的作用域信息等。这样的机制避免了编解码,但是为了避免并发需要对数据进行复制,整个数据基本上是可读的。同时,因为这些上下文保存了类型及函数定义信息等,所以调用者与被调用者仍然还是需要被放在一起编译。因此缺乏可交互能力。

RealityIS通过共享符号表,使得可以从公共的地方获得类型信息,因此不需要放在一起编译。

同时通过赋值解耦的机制,将参数传递分开,因此天生去掉了共享内存的读取(通常是由于无序导致的),因此它可以直接传递数据对象,而不需要执行复制操作。整个程序几乎跟非并发的程序执行逻辑一致。

2.2.8.6 三种模式

如果我们把函数的输出限制只有一个变量,这也是大多数程序语言的规范,那么函数之间的调用有三种模式:

- 自己属性作为参数,其他对象属性作为返回值

- 自己属性作为返回值,其他对象属性作为输入

- 自己属性作为参数,自己的其他属性作为返回值

当然上述的划分也隐含地意味着参与函数交互的对象不超过2个。

通过这样的划分,我们就可以处理任意的程序调用:可以是主动修改别人的模式,也可以是被动消息通知的模式。

但这样的划分对于组件的执行顺序来讲,会存在一些干扰,使得可能没法计算出组件依赖关系,因为它们之间的关系可能存在循环。

一个简单的思路是,考虑到主动式修改的应该是少数,而且具有比较大的影响力,所以我们可以限定主动式(即上述第一种情况)的组件总是最优先执行,只有所有主动式组件执行完了才会执行其他组件,这个时候组件的顺序需要重新计算。

主动式计算替代了传统的消息列表机制,因为:

- 主动式计算总是被执行

- 主动式计算只与当前帧有关,不会缓存消息,实际上它都不需要消息列表,有点类似于传统编程中的立即调用,但是所有的理解调用是并行执行的。

由于主动式组件是在自己的函数内修改其他组件的变量,因此不需要缓存这种一次性的消息。

但是这种对外主动式写入的操作会导致并发冲突。Erlang为什么没有并发冲突就是它没有主动式调用,都是响应式的,任何对函数的调用都是转换为其他函数的消息列表,然后再其他函数内部去解决。

2.2.9 数据与存档

提供数据配置表,以及在脚本中访问数据的机制。

数据存储都自动发生,所以用户实体配置的数据都需要存档,但不需要用户指定。

2.2.9.1 数据配置

2.2.9.2 存档

将玩家的进度数据存档,需要存储至云端

2.2.9.3 不足

将数据跟对象管理起来,不足的地方是数据会随着对象的删除而删除,不像传统的数据是独立存储 在数据库中,删除对象并不会影响数据,然后可以有不同的逻辑把数据加载不同的对象上。这块需要有适当的机制。

2.2.10 通用性

2.2.10.1 独立类

独立的类定义和ECS是等价的,相当于把类的每个方法拆为一个组件,类的实例变量使用全局符号表共享,这样每个组件都可以读写;而Creation Script会区分组件内部和外部变量,因此把一些只有方法内部会使用的变量设置为私有变量,逻辑更加清晰;而传统OOP中,每个类拥有复杂的变量--因此复杂的状态,这些状态有些是表征实例级别状态的,而有些则只是内部两次Update之间的一些临时状态。因此这种划分使类结构逻辑更加清晰,我们能够区分和关注那些真正对外表现自身属性的状态变量。

理论上A和B组件可以完全不需要知道对方的存在,但这种完全无关的交互带来的一个后果是组件执行的顺序非常重要

- 编译器自动识别读写顺序,但这通常最多保证读和写之间,但是多个写之间也有可能有依赖,这种情况无法处理,所以还是需要依赖于后一种情况

- 手动标记执行顺序

2.2.10.2 没有返回值的函数调用

在A和B组件之间设置公共变量,如:

out Global.iHP as iHP如果是A调用B,即A需要向B传递参数,则A的order设置小于B,让A先于B执行即可,这样B执行的时候就可以得到A计算生成的参数

如果一个OOP方法内部有多个其他类的方法调用,则按顺序设置多个组件的order

总之,将OOP中的方法调用顺序转换为组件order的顺序

2.2.10.3 有返回值

- 如果B是辅助方法,可以设置为Library而不是组件的形式

- 如果B是实例,具有自己的实例变量,这个时候需要小心地将两者的方法调用关系拆分到两帧之间:A首先或者B上一帧输出的结果,进行计算,相当于B的返回值;然后A将参数输出,B执行的时候或者A的参数,并将计算结果存入到对用的输出参数;然后A在下一帧或者B输出的参数进行计算

当然,如果原来的OOP类特别复杂,就需要小心地进行重构,如果一个OOP方法内有两个即以上的实例间函数返回值调用,上述的方法就不行,需要对逻辑进行进一步梳理,比如如果是前后没有依赖独立的方法调用,则可以很好滴拆分

2.2.10.4 继承

继承通过组合实现

2.2.10.5 结构体

由于底层的Creation Table Engine需要保证数据是简单的数组结构,因为不能设置太复杂的数据结构,所以不支持自定义结构体,只支持基本类型和矢量等基本类型,其中Vector通过内部结构进行处理

当然其实组件的数据本身可以认为是一个结构体,如果两个组件之间需要共享多个变量,可以通过定义多个out参数实现,这就相当于传递一个隐式的结构体。

2.2.10.6 控制tick的频率

2.2.11 赋值与解耦

传统的赋值语句本身就包含了耦合,它由一个读取语句和一个写入语句构成,虽然从逻辑上来讲没问题,其中包含安全问题

- 读取语句引入耦合,原本我只想给资源增加一定的增加,我并不需要关心总量

- 写入是重写,覆写操作,具有破坏性

尽管程序中有+=操作,但是由于它与写操作是同一权限,能够执行+=操作的变量意味着可以执行写操作,因此仍然具有破坏性

需要将原值读取出来,进行一定的计算,例如加减计算,然后进行赋值,这使得原本对值进行增量的操作逻辑,很容易写到实体外部,即增量来源的地方,这种操作引入了不必要的耦合,因为增量实体根本不需要包含这样的逻辑,但是如果要隔离权限,开发者必须得写一个类似Add(delta)的方法

Machinations 的资源流的一个重要基础,它将两个实体之间的联系,即经济的流动,都看成是增量的,这样经济之间的流动过程中,各个实体就只需要关心自己的事情,然后输入输出一个增量就可以,这个增量本身对两个实体没有任何耦合

生活中大部分其实就是这样的流程,想象一下,你要取100元钱,银行直接给你100,而不是你让银行先把所有钱给你,你拿掉100,再把剩下的钱存回去,如果你在数钱的时候被旁边的人抢走了怎么办呢?

Creation Script 中,组件之间(即对外部变量)的修改支持:

- 增量式修改

- 并且一个组件之间多个修改保证原子性

这使得每个组件只专注于构造自己的增量,大大见减少耦合,并且不需要编写复杂的方法来实现增量修改

如果实在是需要依赖于总量进行计算的,这种少数情况可以先读取总量,计算合适的增量,再对其进行修改

默认增量与默认赋值相比,虽然能实现的功能都没有差异,但是它避免了大部分情况下的耦合,毕竟大部分操作是增量,而且在ECS中在Component 中不适合写方法

编译器也可以进行优化,系统生成更优化的代码,当然这个功能本身不是为代码优化服务的,它是为用户开发效率服务的,能够简化逻辑关系,让用户逻辑更清晰

2.2.11.1 去除直接赋值

剩下操作只有:

- 读取 .

- 增量运算,+=

其中读取操作主要用于:

- 判断资源是否够用,如果不够用的情况下,资源使用方可以方便显示一些提示信息

- 一些依赖于总量的增量运算,例如增加总量的10%

2.2.11.2 拉取还是传入

资源的两种流动模式:

- 流入模式,一般对应于收集资源,此时需要把一定数量的资源传入一个容器,而不是由该容器去拉取,因为它并没有一个拉取源,而是直接对容器执行一个增量计算

- 拉取模式,当我们需要消耗资源已完成某件事情时,通常由完成该事情的实体从资源容器进行拉取,该实体首先对容器执行一个减量计算(当然需要判断容量是否足够),然后执行自己的处理逻辑;

除了生产资源的源头,大部分逻辑都应该是拉取模式。这里主要的原因是耦合:如果需要资源变化的组件主动去修改其他逻辑:

- 这是不合理的,资源的变化组件不应该知道这些逻辑

- 这些逻辑是变化的,可能增加新的逻辑,那么这根本无法实现

所以,应该是由响应组件来拉取,如果某个值变化了,感兴趣的组件自行来读取值进行逻辑处理,这样系统可能随时增加对这些变化感兴趣的新的组件。

2.2.11.3 传递变化的增量

在传统的函数调用中,调用某个函数传递的参数通常是增量值,例如某个技能释放扣除多少血量。这个函数一旦调用完毕,则需要下一次释放技能的时候才会再次调用这个函数。

在OOP的做法是,一个大的函数体,有很多分支,函数首先判断输入,如果适配技能的使用,就进行技能释放分支,然后进而对实际的扣血的函数进行调用;如果没有输入发生或者没有进入技能执行分支,则后续的函数就不会被调用。尽管在这个过程中技能的扣血增量值还是被存放在技能对象中。

在RealityIS中,一切组件都是扁平的,意味着前面不会有这样的分支来阻挡前面的流程,所有组件默认都会被执行。为了实现功能,有两种方法:

- 每个增量属性都对应一个状态量,以说明是否需要执行后续的操作,这实际上是把OOP方法中那些分支转换为状态变量

- 动态增减组件,例如没有释放技能的时候就删除技能组件,这种在实践上很难操作

- 永远传递增量,例如技能组件,如果释放当做执行,修改值就设置为某个具体的数值,否则就设置为0,这样对后续组件没有实质性的影响,这里数值0实际上充当了一个状态值,他告诉后续组件该事件没有发生,但又可以让后续组件不需要处理状态,认为一直在发生。

第三种情况是最简单的架构,但是存在两个问题:

- 性能问题,这相当于传统OOP中那些所有的分支都被执行

- 每帧结束之后或者每帧开始之前,需要对增量值进行清零操作

前者可以通过配合change-driven的架构来实现,而对于后者,例如对于增量组件来讲,它对其他组件的影响是处于外循环,运行时可以在执行完所有被通知组件之后自动清零,这种情况下需要区分哪些是增量属性。

另一种做法是,让主动发生消息的组件自己维护增量值,这样就需要保证这类组件用于都需要执行,不受change-driven机制的影响。例如对于释放技能的组件,它每帧的监听输入,如果输入适配,就将增量设置为预设值,否则设置为0。这种方法应该是最简单的,不能给运行时加入太多逻辑的东西,而且通常发出事件的组件数量是少数的,例如大部分时间时间都是随时输入或者某些用户交互触发的,进而触发一连串的计算,如果源头不会传递,后续的很多计算也间接省掉了,就像OOP中的分支那样。但是相对于OOP,至少可以节省计算,但省不了内存。

2.2.11.4 同时支持拉取和写入

如果全部使用拉取,会存在效率的问题,并且拉取要求被影响着自行支持相关逻辑,这有时候不够灵活,例如已有的组件没有这个逻辑,如果新加一个组件主动去修改这些逻辑,那么修改会变得简单很多。

对于开放型可互操作的程序,也许这样的逻辑是合理的:

- 对用户权限内的组件使用主动写入的方式

- 对用户之间的通信使用拉取的方式

写入的方式倒是很好实现,比如通过writein或者writeout,运行时就可以推导出应该怎样处理。

但是同时支持双向的操作,有可能将使得组件依赖关系不可推导。这方面后续需要好好权衡。

2.2.12 符号泛型

编程语言中实现泛型来针对变化的类型进行自适应或者运行时解析,这些类型通常具有类似的处理流程或操作

但泛型本质上是编程的范畴,进一步,它:

- 一方面是为了节省重复代码

- 一方面是运行时推导类型,但运行时推导类型的需求往往是由于上面一条为了避免代码重复而导致的

- 当然也有单纯是为了支持变化的类型,或者类型作为变量,从这个角度,泛型的定义反而是为了这个服务

类型变量

实体变量

逻辑变量

public Global.HP as hp

public Global.Health as hp

将变量的逻辑映射与变量名区分,在保持逻辑不变的情况下,同一个组件可以处理不同的逻辑,这里“逻辑”本身成为了一个变量,用户可以将一个组件作用至不同的资源类型

传统的泛型要实现类似的功能则非常复杂,你需要把所有变量都转化为对象,并定义接口,然而这种接口非常难定义,因为同样的名称可以用做不同的逻辑,并且这种接口是容易变化的

- 但是数据是不会变化的

- 而且游戏中的逻辑通常修改的资源的数量是比较有限的,通常1,2个,或者3个,以上的很少了

一种不需要约定类型的泛型,只要数据结构类型匹配一样,并且这样类型的检查来源于符号表,而不是运行时

只针对简单结构

复杂结构体,里面的引用名称比较复杂,除非像Lua一样,按索引,但是索引又强调了顺序,顺序通常隐藏在逻辑当中,不过这个顺序倒是可以通过组件说明书说明

2.2.12.1 变量名称

符号表包含数据结构,只能定义结构体,结构体有名称,结构体中的变量也包含名称。

但是组件内部不能定义新的结构,而只能使用元组的数据结构,符号定义到组件变量之间的映射使用模式匹配。

Point

{

X = 10,

Y = 20.0

Z = 30.0

}

2.2.12.2 模式匹配

为了使符号定义与组件变量名称之间进行解耦,可以使用模式匹配。但不能使用传统函数式语言中的=符号,因为我们还是需要赋值符号,这里使用操作符as,但它的意义就相当于FP中的模式匹配。

注意,在Lua中使用索引值来避免调用者跟被调用者之间的耦合,但是这种方式不自然,还是需要引入模式匹配的方式,将值(内存地址)绑定到真正自定义的变量名称上。

CS中的模式匹配只在组件变量绑定时使用,其他组件内部不能使用模式匹配,称为符号绑定更有意义。

变量绑定必须来自于符号表,虽然用户可以替换,但也是替换另一个符号表:

(X, Y, Z) <- Point //read from

H -> HP //write to

通过模式匹配,实现了四个功能:

- 读:即使结构名字或者内部变量的名字不同,只要类型匹配,也可以作为参数

- 泛:可以将默认的Point符号替换为其他结构相同的符号,从而实现符号泛型

- 写:写入数据,不需要单独写入到变量,或者说需要构造数据结构

- 创建:除了获取变量及绑定之外,构造实体的时候,及Spaw函数可能也需要模式匹配。

2.2.12.3 组件内部无类型

实际上,类型主要用于不同类或者实体之间的交互,作为一个多变量的聚合方式,只需要传播单个类型变量名称既可以传递多个变量的值。

但实际上对于一个方法内部来讲,他要处理的全部是单个变量,多变量聚合的名称对于函数来讲没有意义,反而需要更复杂的机制去方法聚合体内部的变量,从这个角度讲,模式匹配简化了这种对实际内部变量的访问机制。

但它带来的不好一面,可能是构造实例的时候不能以一个聚合类型的整体进行赋值,而是需要对其中的每个变量都赋值,但是其实本来也是需要对每个变量赋值的。

2.2.13 并发

面向对象的无序相互引用,通常导致并发,而逻辑上他们不一定有并发,而且我们没有办法从逻辑上去控制这种并发的顺序,太复杂,完全无法预料对象之间以什么样的顺序和时机触发并发。

以组件为单位进行组织,能够更好地控制逻辑的顺序,从而能跟在逻辑上比较简单地避免掉一些不必要的并发

将共享变量和私有变量区分,私有变量不会触发并发,而共享变量因为从符号表引用,从而编译器能够有可能推导出组件对共享变量之间的依赖关系,比如能够把一些相互独立的组件并行执行

以对象为单位,那个对象执行的逻辑太复杂,存在不可预测的分支、跳转等逻辑,那个对象的指针引用可能导致不可预测的指令执行顺序和序列,因而无法很好地使用指令级并行,因此通常只能依赖线程级并行,但不可预测的混乱的对象引用关系将大大地导致并发问题

通过精心将同一组件的数据组织成数组,不光是能够控制逻辑顺序,从而避免一部分并发,同时将对象级别的线程并行转化为指令级并行,进一步,通过对依赖关系的识别能够更好地将多个独立的组件执行线程级并行,这里的核心是能够通过全局符号表和显式共享关系识别依赖关系

2.2.13.1 过程式编程

2.2.13.2 Erlang及OOP

2.2.13.3 适合游戏程序的并发模型

2.2.14 智能感知

当靠近一个物体,或者使用一个特定的探索命令的时候,如果其本身不具备识别对方的操作,可以动态查询对方的属性,然后动态提示是否需要安装新的操作脚本。

因为每个脚本需要用户手动选择,不可能自动安装所有脚本,但是系统本身是可以感知的。

比如购买一辆车,需要使用特定的购买方式等。

两个目标或价值:

- 动态移除:当一个场景中并不包含某个脚本可操作的实体时,可以移除一些组件,或者单纯略过这些组件(出于动态管理的复杂度),比如用户角色可能安装非常多的感知和交互组件,但是在某些场景中根本就没有可与之交互的实体

- 动态添加:有些类型的实体,例如一个广告物体,通常其本身并不包含全场景的机制,他们只是 临时体验

- 智能购买:让用户在试体验某个内容的时候,可以直接一键购买

2.2.15 交易与交互

所有用户之间涉及修改数据的的交互都是交易,当然其他的一般不具备破坏性的交互也可以,例如 读取 数据 。

2.2.14.1 HelpComponent

在一个未知的开放世界,很多东西都是未知的,当面对一个新的实体时,需要能够随时随地获取教程,说明怎样与之交互以及带来的影响

2.2.15 Components

2.2.15.1 NeuralComponent

2.2.15.2 TagComponent

2.2.15.3 RealityIDComponent

2.2.15.4 HelpComponent

在一个未知的开放世界,很多东西都是未知的,当面对一个新的实体时,需要能够随时随地获取教程,说明怎样与之交互以及带来的影响

2.2.15.5 DeltaComponent

参见2.2.11.3节。

2.2.16 最佳实践

2.2.16.1 more granular is better

Bevy has a smart scheduling algorithm that runs your systems in parallel as much as possible. It does that automatically, when your functions don't require conflicting access to the same data. Your game will scale to run on multiple CPU cores "for free"; that is, without requiring extra development effort from you.

To improve the chances for parallelism, you can make your data and code more granular. Split your data into smaller types / structs. Split your logic into multiple smaller systems / functions. Have each system access only the data that is relevant to it. The fewer access conflicts, the faster your game will run.

The general rule of thumb for Bevy performance is: more granular is better.

2.2.16.2 组件顺序

参见2.2.7.1节内容。

2.2.17 关于数据的本质

- 数据是不变的,但是数据结构是变得,我们可以把数据定义在任何地方,这就导致好像一个游戏的数据是不可空的

- 针对数据的操作与数据或者数据类型应该是解耦的,暂且称之为数据泛型

- AI编译器或者AI计算平台能够大力发展,模块化,很好的优化,是因为AI的数据结构特征很明显,或者抽象得很好

- 把数据抽象出来,才更容易看清逻辑的本质,比如易于管理,例如能够判断哪些逻辑可以并行,不然逻辑隐藏于一团乱麻之中,人和计算机都不容易识别其中的秩序

2.2.17.1 数据泛型

生活中,我们会发现,有些方法,道理或者逻辑,他们对许多不同的数据或事物都是相通的,我们可以把这些方法应用在不同的领域,比如一辆车子,他其实可以装任何东西,但是在程序员,一个对象所能处理数据却往往包含额外的类型信息,使得方法的处理不够通用

只要逻辑上能够保证合理,这个可以由用户确定,那么一个逻辑应该可以作用在具有不同意义的相同数据类型上,只要用户指定好输入输出

一种新型泛型

编程语言中实现泛型来针对变化的类型进行自适应或者运行时解析,这些类型通常具有类似的处理流程或操作

但泛型本质上是编程的范畴,进一步,它:

- 一方面是为了节省重复代码

- 一方面是运行时推导类型,但运行时推导类型的需求往往是由于上面一条为了避免代码重复而导致的

- 当然也有单纯是为了支持变化的类型,或者类型作为变量,从这个角度,泛型的定义反而是为了这个服务

类型变量

实体变量

逻辑变量

public Global.HP as hp

public Global.Health as hp

将变量的逻辑映射与变量名区分,在保持逻辑不变的情况下,同一个组件可以处理不同的逻辑,这里“逻辑”本身成为了一个变量,用户可以将一个组件作用至不同的资源类型

传统的泛型要实现类似的功能则非常复杂,你需要把所有变量都转化为对象,并定义接口,然而这种接口非常难定义,因为同样的名称可以用做不同的逻辑,并且这种接口是容易变化的

- 但是数据是不会变化的

- 而且游戏中的逻辑通常修改的资源的数量是比较有限的,通常1,2个,或者3个,以上的很少了

一种不需要约定类型的泛型,只要数据结构类型匹配一样,并且这样类型的检查来源于符号表,而不是运行时

只针对简单结构

复杂结构体,里面的引用名称比较复杂,除非像Lua一样,按索引,但是索引又强调了顺序,顺序通常隐藏在逻辑当中,不过这个顺序倒是可以通过组件说明书说明

2.2.17.2 接口、协议、参数、数据

接口是用来保证类之间协作的协议,这个协议没问题,它保证相互协作

但是在编程语言中,除了协议,它还多了一种身份,充当类型,类型被用于帮助语言进行检查,保证程序的合法性

但这是编程语言的需求,实际上并不是协议的需求,比如,在现实中,A和B协作,它们都会自己遵循一种第三方标准,A和B之间事前不需要相互协商,它们可以与任意遵循标准的实体之间进行交互,就算A和B最终发现它们遵循的标准版本不一样,但是大多数情况是一样的

这里的特点有两点:

- 不同在于A和B事前完全互不通信

- A和B在大多数情况下都能相互协作

- 标准往往是来自独立的第三方

程序语言中往往需要引入接口声明,这种耦合不光是协议本身,还包含了很多协议外的跟程序相关的东西,例如特定的程序包、签名的顺序,甚至有时候依赖的顺序,更糟糕的是,还必须把这些内容插入到代码中

你必须从那个接口继承,而不仅仅是遵循一个接口协议

即使你有自己的方法做了协议一样的事情,这还不够,你必须把代码移到接口方法、包装一下等等,你的修改代码

在遵循协议之外,引入了一些额外的负担

另一个情况是:协议通常关注数据,你能把这个数据进行处理,比如我买了一种特定的原材料,我拿过来进行加工,然后生产另一种材料,卖给其他厂家,我们约定的协议是原材料的规格和品类,但不是我们加工的方法或者步骤,我的方法和流程随时可以变动,只要我输入和输出的规格不变

在程序接口中,本意也是关注输入输出的数据规格,这本可以仅通过定义数据结构即可,但是程序需要保证运行时对象初始化、变量赋值、变量的合法性等等各种原因,他把输入输出数据和方法放到了一起,这里面也有更重要的原因是实时性和顺序:调用方需要立即获取返回结果

这使得编程语言的协议约定的更像是方法而不是数据,又加上编译器的类型系统等原因,协议被深度耦合在系统中,增加了复杂性

CreationXR仅关注数据及其结构,并且通过游戏特有的Update机制也能保证返回值被立即取得,但是它弱化了对方法相关的依赖,而数据可以通过公共符号表定义,不管是基本类型还是聚合类型

这种解耦大大的简化了程序组织的复杂性、也增加了灵活性,例如可以随时增加感兴趣的数据,或者执行不同的逻辑,但其他部分完全不受影响

当然带来的一个新的问题是:这种隐式的参数传递导致组件的实际目标并不是很明确,因为它很有可能做了一些不可控的事情,这种需要对组件功能进行描述,就像一个产品说明书,他到底做了什么,这样的说明书是普通用户可以理解的,语义化的

2.2.18 游戏程序跟传统程序的区别

2.2.18.1 Update机制

Update是游戏的核心驱动力:

- 它既是形成动态世界的基础

- 同时又由于每个对象都在实时更新自己的状态,因此使得系统之间的解耦变得可能,即每个子系统只需要处理自己的状态

传统的应用程序只操作业务规则,没有实体化,他们通常面对的是数据,数据结构,这种数据通常反应的是规则,而不是对象得概念

2.2.18.2 程序大小与空间数据结构

传统应用程序的程序包大小都比较小,例如一个手机app只有几十最多上百M,但是一个游戏往往都多大几个G,主机游戏甚至几十到上百G。

不光程序包的大小,计算时加载到显存的数据量更是差异巨大 ,例如应用程序通常只需要加载少量有关的数据,常驻内存中的数据通常不多,每个业务逻辑相关的数据通常都比较独立,即使少量单个逻辑需要的数据量比较大,也仅需在计算的时候即使加载就像,传统的应用程序通常对实时性要求没那么高。

而游戏程序内的数据通常高度关联,且包含空间数据结构,所以往往数据会非常大,且大多需要常驻内存,使得现代游戏程序的显存往往是不够的。空间数据结构不仅意味着比一般的数据量要大,而且为了加速计算,通常还需要包含很多冗余的数据和数据结构来达到实时性。

当未来的虚拟开放大世界需要更大的数据,这些数据可能远远超出单台计算机能够承载的显存大小。在这种情况下,这样的大世界将很难有效地运行,需要新的技术架构来支撑这种扩展需求。

2.2.18.3 架构复杂度

2.2.19 状态机、行为树与AI

2.2.20 安全

如果要让来自不同开发者的程序可以在一个内存环境运行,以及来自不同用户的实体对象在一个内存环境中进行交互,安全性是一个非常大的问题。这里的安全性涉及两个层面:

- 代码bug引起的程序崩溃

- 代码蓄意破坏系统和他人数据

后面通过严格控制程序实例化对象来实现,通过Creation Script的机制,开发者:

- 无法分配自己的内存

- 无法访问指针

- 甚至无法构造类型

- 无法访问系统带有众多数据的结构,例如场景树

所有提供给开发者的接口都要保证用户和系统安全性

2.2.21 组合与依赖

2.2.21.1 相关参数聚集到一个对象

大量中间变量:将嵌套的函数结构转化为扁平结构,其代价是存在大量中间变量属性,尽管这些变量不能算是破坏了纯函数的结构,但是他们带来一定的干扰,并且大量的中间变量如果都存储起来,既是不必要的,也浪费内存。

此外,由于在RealityIS中组件属性并没有严格的所属关系,它不是由单个组件拥有的,也不是由单个组件定义的,这也是RealityIS的核心机制,所以我们也不可能简单地通过在属性上加入一些变量attribute 来声明属性是否应该被存储。

由于属性并不是在使用的地方定义的,即不是在组件中定义的,这跟传统编程也是一个核心区别,RealityIS属性定义的地方在符号表中,这是唯一定义的地方,所以我们可以把这些attribute 定义在符号表中,即只有符号表要求存储的变量才会被持久化,其他数据都认为是中间变量。

但是也不能为了持久化把中间变量都放到私有表中,那样就不具备跟其他组件通信的能力,全局符号表的主要目的之一就是为了互操作性,所有需要互操作的都需要定义在全局表中,到全局表也有不需要持久化的属性。

中间变量存在于私有表也可以,但是他可能需要关联组件,使得计算的最终结果是一个全局符号表中的属性。

2.2.21.2 关联组件

事实上我们是否应该要求私有表中的符号总是不应该持久化,这样就会更加迫使开发者针对公共可交互属性进行开发,否则开发的组件将没有任何用处。

这带来两个好处:1是组件不再于单个独立组件的形式存在,而且一个相关联的组,这样的组更容易管理,粒度更大一点,2是标准的地位更高,所以组件真正是必须依赖于标准,更容易管理,整个程序机制更容易理解。

对于一个组件,不管中间状态如何,他的第一个输入(或者多个参数的其中之一)必须是全局符号表,然后最后一个写入的属性也必须是全局符号表,中间的大量属性属于中间属性,来自私有表,不会被持久化,所有这一连串的组件成为关联组件,他们形成依赖关系,而所有相互依赖的组形成一个纯函数。

但一个组件组中的所有函数如果均是作用于一个实体对象,则他们可以合并为一个大函数,因为反正中间过程别人无法交互,所以没有必要拆分。

拆分成多个中间变量适合于:这些变量可能分布于多个实体的时候,或者说的输入来自于多个实体,这种情况必须要借用中间变量才能实现。

所以理论上说,只要输入全局符号参数大于等于2,就需要某种形式上的中间变量,来进行归并。

所以也可以定义一种重载的机制,如果某个对象同时包含了多个参数,可以减少中间变量的归并过程,可能会有一定程度的性能提升,但是对架构简洁性造成的代价可能有点大,带来编码和运行时的复杂度。

一个大的组件组由多个小组件组合在一起,这些小组件构成一个较大逻辑的复杂细节,而组件组则是用户进行创作的单位,组件组内属于开发者进行维护的单位。

如果开发者的组件是多个输入参数,来自全局符号表,则他应该知道只有同时满足这些条件的单个对象才能执行计算,否则他应该始终假设单变量输入的形成,通过中间变量组合。

2.2.21.3 组件顺序

2.2.22 分布式

2.2.23 异常

由于RealityIS将一些完整的操作分散到多个组件当中,单个缺乏原子性,因为它可能是与其他组件一起构成了整个完整计算。所以我们不能像Erlang那样采取丢弃单个进程的方式,因为在Erlang中一个进程崩溃了并不会影响到其他进程,而且Erlang单个进程的任务比较独立。而RealityIS中某些组件崩溃了,意味着前面某些计算也需要取消。

因为RealityIS将采取非常不一样的异常机制:

- 如果一个组件崩溃了,整个该帧的所有计算都需要丢弃

比如采取响应式,如果一个炸弹爆炸了,但是后续对炸弹进行相应的组件却崩溃了,这个时候前面的炸弹就无效了。如果是一些其他更重要的逻辑发生,这样的影响就会非常严重。

当然传统游戏的做法是,当一个地方导致程序崩溃了,游戏会从一些固定的存档节点恢复,玩家需要从那些固定存档重新开始玩,这可能会带来一定的重复。

重复肯定是必须的,问题是对于一个没有关卡的开放世界,它的存档节点是非常复杂的。系统需要一套自动化的存档机制。

2.2.23.1 自动存档

构建一个存档机制,然后崩溃之后提示用户退出,并自动回退到上一个存档快照状态。

另一个情况是,尽管很多用户共同在一个开放世界运行组件,但是大部分组件之间的通信还都是在RealityID之内的,所以一般情况只需要退出单个用户即可。但也有可能某个跨用户之间的通信会影响到多个用户。

因为内容是由普通用户创建的,所以需要避免传统游戏设置的专门的存档节点的机制,原因是:

- 普通用户很难有这样的能力,存档往往是要打开程序的结构的,增加复杂性

- 开放式的世界其实很难设置存档节点

但每帧存储肯定代价值很大的,所以也要避免每帧存储。

2.2.23.2 检测存档属性

当属性定义为存档属性时,如果其值发生了改变,理论上这些修改都要存储起来。

比如玩家在攻打一个Boss,这其中需要花费大量的精力,通常几分钟甚至十几分钟,这期间Boss会有很多状态变化,玩家的动作、动画状态、行为树等等也会发生很多变化、环境中的树木也可能临时被炸掉等等。但其中除了用户使用的技能道具等,其他大部分数据都不要存档。

Boss战存储的更多是一个大的结果,这样当其中出现崩溃时,玩家可以重新打Boss。

2.2.23.3 属性独立存档

对于实体对象的属性数据,可以不采用传统的属性结构进行存储,因为那样就会存储到一个文件,使其存档时会发生并发。

因为其实体对象属性本身是Table结构的,所以我们可以向内存访问一样,每次修改一个属性之后,这个属性利用虚拟内存系统自动存储到硬盘,然后等玩家退出或者程序崩溃的时候再统一存储到用户的数据存储服务器。

这样所有实体对象在云端存储的也是Table,不必存储到一个USD文件中。实际上在内存中它们也不必存储到一个数据结构,例如一个树形的数据结构。只有这样才能保证分布式计算。

将一个IO拆分为多个IO,可能会带来一定性能损失,但是考虑:

- 单个IO或者少数IO只能采用少量线程,如果是大文件解释也会很慢,没法有效利用多线程加载

- 现代NoSQL数据库对缓存,某些查询做了大量的加速,效率要大于单纯的文件或数据区查询

总之,这可以利用到多线程的优势,又能保证分布式。

2.2.23.4 存储时间点

总的来说,有两个存储时间点:

- 用户退出应用时

- 用户的某个组件进程导致崩溃时

CreationVM会包含两份数据:

- 一份是所有组件的运行时数据

- 一份是所有组件的存档数据

当运行时组件修改了某个存档属性,这些值会被记录在内存中。开发者和运行时应该保证一旦这些值被修改,其之前的操作都是合法的、原子性的、不可修改的。所以这些数据可以被随时写入到用户真正的数据库文件中。

只是因为频繁写入数据库的IO操作,我们选择在一些关键事件发生时在写入数据库。在这种机制下,如果CreationVM机器本身崩溃,有导致有些属性没有被存档,因此下次用户需要重复执行某些操作。但是这并没有太大问题,游戏玩家已经习惯这种机制。

基于上述的机制,当用户组件进程发生崩溃时,由于CreationVM的存档属性并不包含一些中间值,所以所有这些都不会被写入到数据库。反之,CreationVM接收到崩溃通知之后,会立即将之前的存档属性写入的数据库,并写入崩溃日志。用户退出应用时也是同样的逻辑。

该机制的成功运作需要开发者和运行时协同工作:

- 开发者要保证当对一个存档属性进行修改时,之前的所有操作都是合法的,运行时可以放心存储这些数据

- 运行时需要保证,如果组件在存档属性的修改之前没有任何问题,那么运行时需要保证对存档属性的写入应该也不会出现问题

所以,一个组件的返回值应该始终位于函数的最后,不能再中间返回,或者对返回值对象赋值,或者写成以下方式更好:

(x, y, z) = Global.Position

Global.HP = map() {

...

x + y + z

}

最后一个字句默认是返回值,不需要return关键字,它返回的值会赋值给Global.HP,这里仍然通过模式匹配,使开发者不需要去关心Global.HP的内部结构。同时省掉了一些声明,如果跟输入变量一样的声明形式会多写一些无用的代码。

2.2.24 组件属性

.Component(name) //组件文件名和名称

.UseDt(true) //是否使用dt参数,一般用于动画或者跨帧行为

2.2.25 数据和组件之间的关系

数据和逻辑是程序的两个最基本元素和概念,有了这两个基本元素,我们基本上就可以编写任何程序。

2.2.25.1 大规模程序构造方法

然而,真正的软件规模是非常大的,它往往是由众多的开发人员(这些开发人员甚至可能在地理位置上完全隔离)开发的几十甚至上百万行代码的组合,这种规模的软件程序显然不可能仅由简单的变量和函数构成,那样的话我们将很难无管理错综交织、复杂的数据和函数引用。

为此,编程语言的设计者在数据和方法的基础上,添加了大量的抽象机制,例如类型、数据结构、继承、多态、重载、接口等等。这些机制的目标是要形成各种抽象,使得:

- 其他人员可以不需要关心一些实现细节,只需要关心与之交互的部分,即接口;

- 当然除此之外,这种抽象也是帮助开发人员自身从逻辑上更好地管理自己所编写的众多代码。

所以现代编程语言的发展,本质上都是在解决大规模软件构造的问题,现代编程语言主流的两种软件构造思路是面向对象和函数式编程。

2.2.25.2 数据和逻辑和问题

参见2.7.13.3节,RealityIS中的实体对象代表的是逻辑,即复合函数,因此实体对象从概念上仅包含逻辑,不包含数据,这也是简化用户组织逻辑的关键,即用户不需要关心数据,关心的仅仅是功能。

那么数据在哪里?以及数据是什么样的概念?

如果说数据被隐藏起来,它在哪里以什么形式存在呢?从用户层面来讲,表面上看数据仍然是附着于实体对象的,因为用户添加了某个函数或者复合函数之后,实体对象将会显示相应的参数,用户需要知晓这些参数来了解函数之间的逻辑关系。

但这些数据本质上是不需要用户管理的,RealityIS认为,所有数据都是用户数据,即所有数据是一个用户的巨大数据表,当我们创建一个实体对象以实现某个功能时,我们实际上是对这个大的用户实体对象中的某些属性进行修改,而从数据表中查询和写入数据的操作则由系统完成。

当然实际上并不是运行时动态从数据表中查询数据,那样就变成传统的面向数据库编程的模式,我们实际上是根据对象组件与数据之间的关系,在初始化的时候从数据库中找出这些数据,并按照对象的形式分散存储在内存中的各个位置,整个运行时的行为实际上跟传统的面向对象编程,更确切地说ECS的内存布局是类似的。

这种看待和处理数据的方式,是RealityIS与传统编程模型的巨大差异。

2.2.25.3 基于组合的构造方法

\2. “有”和”能”和实现

在组件模型中,对象由组件组成,所以其行为也由组件主导,例如一个对象拥有[Movement] 和 [Location],则我们可以认为它能够移动,这在整体上是十分和谐自然的,但当我们仔细考量,这个"能"是由于什么呢,是因为 [Movement]吗,是因为[Location]吗,还是同时因为 [Movement] 和 [Location]?当然是同时(这里便揭示出了组件和接口的展平对象方式是正交的),那移动的逻辑放到哪呢?答案是放在这个“切片“上。但在实际项目中会看到把逻辑放在 [Movement] 上的做法,这两种方式都是可取的,后一种拥有较为简单的实现并被广泛采用,而前一种拥有更精准的语义,更好的抽象(后一种种方式中 [Movement] 去访问并修改了 [Location] 的数据,这破坏了一定的封闭性,且形成了耦合,当然这种耦合也有一定的好处,如避免只添加了 [Movement] 这种无意义的情况发生)。

作者:BenzzZX 链接:https://zhuanlan.zhihu.com/p/41652478 来源:知乎 著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

2.2.25.4 数据是二等公民

2.2.25.5 组件是一等公民

2.3 Creation VM

跟引擎高度一体化,不是独立的虚拟机

2.3.1 Creation Table Engine

Table Engine维护一个Database,主要目标:

- 构造和存储所有基于Data-driven的数据,包括Component的数据、事件列表、Hierarchical Level数据、行为树/状态机等结构,所有数据都已数组的形式组织。

- 对Table数据进行新增、删除、修改、排序等操作。这些操作都需要延迟到Component进行后统一进行处理,而不是立即处理。

- 对于Component的数据,由于所有数据混在一起,需要按照ArchType进行组织。并且块元素的大小进行自动计算。

提供一些标准编程案例

虚拟机的设计:

如果数据都是Table类型的格式,那么动态需要的虚拟机可以设计为处理原生类型,所有Table数据的分配和管理都交给系统层,这样脚本需要生成的代码也为“纯代码”,这些字节码对应的操作数地址的分配则为C++层的编译型代码,而不是动态解释

避免了脚本语言复杂的数据地址分配:例如构造虚拟寄存器或者虚拟栈,以及对应为了构建虚拟寄存器而构造的符号表以及符号表的解释映射等

所有的代码,在虚拟机这一层都是转化为对table的某种操作,这些操作都封装为基础的C++层的代码,自动就处理了内存地址的分配

要拆解Table的基本操作,也就是STL中基础Vector的基础数据操作,应该能够提炼出所有可能的基础操作,然后封装为虚拟机层的高级基础指令

这样整个Table Library 就是一个类似STL的库,它封装一些特定的Table的操作类型和操作方法,面向数据驱动的整个架构,既支持原生C++调用,也支持虚拟机基础指令封装,这就好比Lua的某些方法由C实现,只不过这里的C操作是更低层的操作,并且这里的数据由C定义和分配,而不是像Lua一样由Lua分配再传给C,所以这里脚本语言的定义语言处理特殊的变量操作,例如脚本语言中对变量的使用都翻译为对C对象的使用,没有变量复制,没有数据只有指令

如果脚本语言中不含结构声明,或者没有自己的结构体,只有简单变量,那么整个解释过程是不是会快很多

2.3.1.1 数据存储:数组

为了实现每个组件的单独编译,首先组件访问的数据得是独立的,另外这些数据的布局得是固定的。

对于组件需要访问的每个变量,使用指针的方式是非常复杂的,因为这意味着虚拟机需要动态给每个组件中的每个地址赋值,这几乎是不无做到的,因为虚拟机只处理规则的内容,通用性的规则,但是每个组件对数据的访问确实不一样的,除非是解释器或者虚拟机自己分配的内存,但是这里一个实体的组件的数据不是由组件代码自己分配的(你如传统的寄存器寻址,就是解释器或者编译器直接针对代码设置好寄存器地址),而是由Creation Table自己分配的。

为了实现这种分离,组好的方式就是将组件访问的数据放在一个连续的内存地址中,然后:

- 虚拟机只要动态将起始地址传递给组件,这种规则是通用的

- 解释器将每个组件中的寻址转换为基于相对位置的寻址

这有点像虚拟机中执行函数调用,当然这里只采用栈式方法,所有函数需要访问的变量存储在一个栈中,函数按索引对栈中的内存进行访问。

2.3.1.2 无类型定义与垃圾回收

只有组件类型,组件只有数据,没有新的结构体定义,全局符号表中有一定的基础数据结构,但是其他的数据结构均有组件的数据定义隐式决定。

由于类型定义在脚本语言中,并且是按照单个组件的类型进行定义的,即AOS(array of struct),两个原因 :

- 第一并不利于高性能 计算,高性能计算需要是SOA的形式

- 其次,底层虚拟机并不了解组件的数据结构,导致不能动态构造对象;因此需要在脚本语言层面直接构造对象,这样脚本语言就需要实现复杂对象,及其相应的垃圾回收机制;

对于上述两个问题,Unity使用了离线编译的方式,将组件数据的构造转换成了另外某种形式的中间代码;这样使得可以SOA的形式进行 数据管理,但是它 可能不支持动态更新,或者至少需要动态更新整个编译后的中间代码?

当CTE试图将 上述过程放到运行时动态解析时,性能是需要重点考虑 的事情:

- 单纯A OS->SOA的开销

- 以及当场景中有 大量对象时 ,这些对象之间的数据关系等等的判断可能会非常 消耗时间

所以需要好好划分阶段,并把部分数据是否可以提前计算出来,例如对于一个Creation:

- 首先确定它引用的所有变量及其组合关系,这部分是否可以预计算成 某种格式,即是计算ArchType的时间,这些可以 在云端下载 资源 的 时候计算 好,下载时动态计算。

- 然后运行时首先就可以根据这些关系初始化数组

- 如果涉及用户在端侧编辑数据,则针对每个对象动态修改 ,但此时应该不会太影响性能。

因为这种AOS->SOA的转换,使得上层脚本语言定义的对象可以在虚拟机上进行初始化,从而减少脚本层面的复杂度,并使得原生语言 管理对象性能更高效。而这种转换机制背后的核心因素是两点:

解释器动态识别组件定义的数据结构,并从中提取属性及其符号

以及底层ECS的机制将这些属性转换为SOA数组,由于整个CTE都是已知基础数据类型的数组,所以间接地不需要关注上层 脚本实际的数据结构,每个元素按照索引进行寻址即可。

整个Table中没有任何未知Struct对象,所谓未知即是用户定义的struct。这里面的核心就是解释器动态对变量的内存地址进行重新映射,通过数组索引+基础变量类型,就能计算出正确的索引位置。因为数据在内存中是没有struct的概念的,struct的作用在于帮助编译器或者解释器计算内存中的索引位置。

当然,我们不能支持用户端自定义struct,否则虚拟机无法识别,就需要复杂的机制来识别结构体。由于游戏的特殊性:它能够将所有数据通过ECS的机制转化为Table,所以我们有就会去除掉结构体或者相关的类型解析,变成更简单的索引计算。

当然,为了考虑性能,这里可能需要考虑AOT的机制,即提前将索引的计算转化为中间形式,不然每次要通过虚拟机中的索引映射方法来动态计算索引,性能开支就会比较大。但是由于这个索引是跟运行时的动态相关联的,所以需要在对象的创建/修改/删除等环节进行重新动态计算。

2.3.1.3 运行时内存管理*

尽管Table中的数据在不断变化,但是这部分的变化在某种程度上跟垃圾回收的思路类型,例如:

- 当某段连续的内存不够时,需要重新度数据的布局进行调整

- 当某写对象不再使用时,垃圾回收器可能需要对某段内存数据进行擦除

- 记录对象之间的索引,关系等等

因此,这部分思想可以参考垃圾回收的一些思想和算法。

2.3.2 Add、Remove

对数组的操作一般由Component发起,但是不能立即对Table进行修改,因为其他Component正在访问这些数据,这些修改需要延迟到Component和其他操作执行完毕,需要使用诸如缓存队列之类的架构。原则就是:

- 数组结构的修改需要单独不理,不能影响当前操作

2.3.3 Change-driven Update

在每一帧中,每个组件通常做三种类型的事情:

- 不做任何判断,把整个逻辑完整执行一遍,哪怕其中涉及的数据没有任何变化(因此结果也不会有任何变化),这种计算策略是非常浪费的,但是它确是管理成本最低的方式。

- 第二种类型包含逻辑判断,因此一部分计算指令集于某些属性值的不同可能不会被执行

- 第三类是包含一些需要跨越多帧执行的逻辑,例如动画,它们通常只执行一段连续的时间,在这段时间里,由于属性数据都在发生变化,所以它需要像第一种方式一样完整执行;但是一旦这段时间结束,它可能就不再需要被执行。

对于第一和第二种类型,理论上它们都可以归结为一种,因为如果所有输入数据都不发生变化,那么理论上结果也不会有变化,因此可以不用执行。理论上第一种情况可以把某些属性数据作为判断条件,然后第一种情况就变为第二种情况。对于这两种情况,也有可能判断条件会包含多个,因此根据ECS的思路可以拆分,至少拆分成一个组件只包含一个判断条件。

如果一个组件只包含一种判断条件,那么就可以把这个判断条件设置为一个观察值,只有这个值发生变化时才需要完整执行整个组件的逻辑。这就是Change-driven update的核心思路。当然处于简单,我们只判断值是否发生变化,而不是检测更具体的条件,例如一个逻辑条件是变量a大于10,那么a由3变成4也是触发逻辑更新。但是将逻辑判断附加到属性值上则会非常复杂。

这对于一些包含复杂计算或者涉及较大数据加载的组件都是非常有益的。而且对于开发者来讲也不算复杂,可能就是每个组件定义一个或者多个状态变量,并知道这几个变量需要检测即可。当然需要开发者去判断是否这些值的变化能完全决定或覆盖整个逻辑计算。

只有修改过的数据才会Update

2.3.3.1 理论基础

在RealityIS中,每个组件理论上是一个纯函数,即如果输入没有发生变化,那么输出也不会发生变化,所以我们可以监测输入,只要输入的值没有发生改变,我们就不需要对其相关的组件进行计算。

当然这里动画是个例外,以及一些自行定义跨帧计算逻辑的组件,所以这可以通过组件的属性进行设置,要求是否对输入进行监测,以驱动组件计算。

.ChangedDriven(True)

当然参见2.2.3.3节可见,由于我们将所有跨帧状态看做是dt的函数,需要在每帧进行重复计算,所以组件函数本身仍然是纯函数,这里实质上是将dt也看做了一个 输入参数,而其他的组件可能是不会使用组件参数的。所以这里将组件属性名改为:

.UseDt(True)

可能更合适。

这里表面上看,好像可以通过函数是否引用dt进行自动推导,但是有一些特殊情况,例如函数只是使用dt来生成随机数,并不是计算跨帧状态。所以我们还是不能对dt的使用有任何假设。

2.3.3.2 管理与调度

总的原则,输入变化了才会导致组件执行这件事情是不需要让开发者感知的,更不应该需要它来控制这个过程,因为运行时是完全能够计算/推导出这一切的。当然,动画除外,或者更确切地说,是那些不依赖于输入,而自行定义了私有变量的组件,这些组件之所以定义私有变量,其目的就是在相同的输入下可能存在不同的输出,这就是传统OOP中状态的影响。参见2.2.3.3节。

在Bevy中,它依赖于由程序员决定一个组件是否对某个Component造成了修改,他需要每个组件使用mut关键字的查询,这样系统就可以判断其值是否可能被修改,但是不可修改的通常是少数。

跟Unity不一样,我们不能把Version Number暴露在Query中让开发者去比较,因为这本可以自动进行的。何况在Query中进行计算,这个组件的函数仍然进去了,只是进去之后才发现不需要计算。这个判断的固定结构完全可以交给运行时去管理的。

CreationVM运行时需要对每个块进行追踪,如果发现没有修改并且不是动画类型的,就不需要进行组件计算。

2.3.3.3 变更的判定

由于上述冗余的存在,不可能保证每个组件只有当输入发生改变的时候才进行计算,可能会存在大量重复计算。此外,即使是不同的输入,也可能存在相同的输出,因此,我们不能像Unity/Bevy那样仅凭组件是否对属性进行写操作来进行判断。

而且写操作这种逻辑是不变的,意味着如果存在大量的浪费,那么这种浪费会一直持续,这本身是一种结构性特征,可以交给运行时拉处理。

显然,我们需要对每个值进行判别来决定其属性是否发生变更,但由于组件处在并行计算中,不能统一对一个块设置一个isChanged变量,为了避免对共享变量的写操作,需要使用和组件数据一样的方式。

这里可以针对每个块中的每个可写属性设置一个通用的整数数组,当然还是SOA的形式,使得它们好像组件的另外一个属性,只是这个属性是由块进行管理的,而实体或者组件是感知不到的。

当组件函数对输入值进行写操作的时候,编译器会自动为机器码加入一段函数,这端函数其实做了一个判断:如果赋值的值与原来的值不一样,则对应实体对象对应的值为1,否则为 0。所以比如一个包含8个实体对象的块,其计算完之后的值如果没有发生改变,则值为:

00000000

如果其中的任何值为1,则意味着其值发生了改变,所有后续依赖于该属性的组件都应该执行计算。

对应的调度器应该把这个改变的状态传递给所有引用该属性的块。然后在这些块计算的时候,首先进行判断,除非所有值都为0,否则整个块都需要执行计算。

通过这种方式,每个块只需要保存一个数字,通过使用特殊的对位进行操作的寄存器分配,我们甚至每个对象只需要占用一个bit的存储,这个大小跟Unity DOTS的Version Number占用的存储差不多,但是其原理完全不一样。

并且基于值(而不是逻辑)的比较更可靠,通过编译器的适配,性能开销也几乎可以省略。

2.3.3.4 Version Tracking

![]()

Change tracking is a hard problem to solve efficiently and robustly. It’s easier to make it a responsibility of the content creators. They define what is static and what is dynamic. Unity doesn’t want to add complexity to content creators.

Fortunately the DOTS architecture has a nice solution for this problem. DOTS queries define read and write access properties to each component included in the query. This helps with scheduling, as multiple reads of the same data are race free and can be executed concurrently.

Since the write access is tracked explicitly and misuse is guarded by the compiler, we know which component arrays in each chunk were potentially modified.

To implement a “free” data version tracking system, we add a version number to each component array in each chunk. When write access is requested, the array version number is bumped to the global version counter, which is monotonically increasing. Systems store previously seen global version counter value. This value can be used as version change filter in future queries, to limit the query over chunks that have changed since the system saw them previously. This change tracking system is more robust than dirty flags and doesn’t require any additional bookkeeping.

We rely heavily on DOTS change tracking in the hybrid renderer.

Version numbers

Version numbers (also known as generations) detect potential changes. You can use them to implement efficient optimization strategies, such as to skip processing when data hasn't changed since the last frame of the application. It's useful to perform quick version checks on entities to improve the performance of your application.

This page outlines all of the different version numbers ECS uses, and the conditions that causes them to change.

All version numbers are 32-bit signed integers. They always increase unless they wrap around: signed integer overflow is defined behavior in C#. This means that to compare version numbers, you should use the (in)equality operator, not relational operators.

For example, the correct way to check if VersionB is more recent than VersionA is to use the following:

bool VersionBIsMoreRecent = (VersionB - VersionA) > 0;

There is usually no guarantee how much a version number increases by.

EntityId.Version

An EntityId is made of an index and a version number. Because ECS recycles indices, the version number is increased in EntityManager every time the entity is destroyed. If there is a mismatch in the version numbers when an EntityId is looked up in EntityManager, it means that the entity referred to doesn’t exist anymore.

For example, before you fetch the position of the enemy that a unit is tracking via an EntityId, you can call ComponentDataFromEntity.Exists. This uses the version number to check if the entity still exists.

World.Version

ECS increases the version number of a World every time it creates or destroys a manager (i.e. system).

EntityDataManager.GlobalVersion

EntityDataManager.GlobalVersion is increased before every job component system update.

You should use this version number in conjunction with System.LastSystemVersion.

System.LastSystemVersion

System.LastSystemVersion takes the value of EntityDataManager.GlobalVersion after every job component system update.

You should use this version number in conjunction with Chunk.ChangeVersion[].

Chunk.ChangeVersion

For each component type in the archetype, this array contains the value of EntityDataManager.GlobalVersion at the time the component array was last accessed as writeable within this chunk. This does not guarantee that anything has changed, only that it might have changed.

You can never access shared components as writeable, even if there is a version number stored for those too: it serves no purpose.

When you use the WithChangeFilter() function in an Entities.ForEach construction, ECS compares the Chunk.ChangeVersion for that specific component to System.LastSystemVersion, and it only processes chunks whose component arrays have been accessed as writeable after the system last started running.

For example, if the amount of health points of a group of units is guaranteed not to have changed since the previous frame, you can skip checking if those units should update their damage model.

EntityManager.m_ComponentTypeOrderVersion[]

For each non-shared component type, ECS increases the version number every time an iterator involving that type becomes invalid. In other words, anything that might modify arrays of that type (not instances).

For example, if you have static objects that a particular component identifies, and a per-chunk bounding box, you only need to update those bounding boxes if the type order version changes for that component.

SharedComponentDataManager.m_SharedComponentVersion[]

These version numbers increase when any structural change happens to the entities stored in a chunk that reference the shared component.

For example, if you keep a count of entities per shared component, you can rely on that version number to only redo each count if the corresponding version number changes.

2.3.3.5 Bevy's Change Detection

Bevy allows you to easily detect when data is changed. You can use this to perform actions in response to changes.

One of the main use cases is optimization – avoiding unnecessary work by only doing it if the relevant data has changed. Another use case is triggering special actions to occur on changes, like configuring something or sending the data somewhere.

Filtering

You can make a query that only yields entities if specific components on them have been modified.

Use query filters:

Added<T>: detect new component instances

- if the component was added to an existing entity

- if a new entity with the component was spawned

Changed<T>: detect component instances that have been changed

- triggers when the component is accessed mutably

- also triggers if the component is newly-added (as per

Added)

(If you want to react to removals, see the page on removal detection. It works differently and is much trickier to use.)

/// Print the stats of friendly players when they change

fn debug_stats_change(

query: Query<

// components

(&Health, &PlayerXp),

// filters

(Without<Enemy>, Or<(Changed<Health>, Changed<PlayerXp>)>),

>,

) {

for (health, xp) in query.iter() {

eprintln!(

"hp: {}+{}, xp: {}",

health.hp, health.extra, xp.0

);

}

}

/// detect new enemies and print their health

fn debug_new_hostiles(

query: Query<(Entity, &Health), Added<Enemy>>,

) {

for (entity, health) in query.iter() {

eprintln!("Entity {:?} is now an enemy! HP: {}", entity, health.hp);

}

}

Checking

If you want to access all the entities, as normal, regardless of if they have been modified, but you just want to check the status, you can use the special ChangeTrackers query parameter.

/// Make sprites flash red on frames when the Health changes

fn debug_damage(

mut query: Query<(&mut Sprite, ChangeTrackers<Health>)>,

) {

for (mut sprite, tracker) in query.iter_mut() {

// detect if the Health changed this frame

if tracker.is_changed() {

sprite.color = Color::RED;

} else {

// extra check so we don't mutate on every frame without changes

if sprite.color != Color::WHITE {

sprite.color = Color::WHITE;

}

}

}

}

This is useful for processing all entities, but doing different things depending on if they have been modified.

For resources, change detection is provided via methods on the Res/ResMut system parameters.

fn check_res_changed(

my_res: Res<MyResource>,

) {

if my_res.is_changed() {

// do something

}

}

fn check_res_added(

// use Option, not to panic if the resource doesn't exist yet

my_res: Option<Res<MyResource>>,

) {

if let Some(my_res) = my_res {

// the resource exists

if my_res.is_added() {

// it was just added

// do something

}

}

}

Note that change detection cannot currently be used to detect states changes (via the State resource) (bug).

What gets detected

Changed detection is triggered by DerefMut. Simply accessing components via a mutable query, without actually performing a &mut access, will not trigger it.

This makes change detection quite accurate. You can rely on it to optimize your game's performance, or to otherwise trigger things to happen.

Also note that when you mutate a component, Bevy does not track if the new value is actually different from the old value. It will always trigger the change detection. If you want to avoid that, simply check it yourself:

fn update_player_xp(

mut query: Query<&mut PlayerXp>,

) {

for mut xp in query.iter_mut() {

let new_xp = maybe_lvl_up(&xp);

// avoid triggering change detection if the value is the same

if new_xp != *xp {

*xp = new_xp;

}

}

}

Change detection works on a per-system granularity, and is reliable. A system will not detect changes that it made itself, only those done by other systems, and only if it has not seen them before (the changes happened since the last time it ran). If your system only runs sometimes (such as with states or run criteria), you do not have to worry about missing changes.

Beware of frame delay / 1-frame-lag. This can occur if Bevy runs the detecting system before the changing system. The detecting system will see the change the next time it runs, typically on the next frame update.

If you need to ensure that changes are handled immediately / during the same frame, you can use explicit system ordering.

However, when detecting component additions with Added (which are typically done using Commands), this is not enough; you need stages.

2.3.4 编译

由于System是不依赖于数据及数据结构的,它只包含一个相对索引地址,每个System使用的所有数据都可以通过这个相对索引地址进行查找,所以编译器只是计算了每个变量的一个索引地址,通过堆而不是堆栈指针的方式。

因此,每个组件在开发完成之后它的编译工作就结束了。

而在实际运行的时候,用户请求一个实体,云端会根据这个实体配置(对组件的引用),对实体的数据进行组织,它会根据System对数据的使用定义,将这些数据精心组织在Creation Table中,然后再将适当的数组及其索引发送给System的代码进行执行即可。

所以:

- 在编辑器Reality Create中,开发者每写完一个组件(例如一个System)都会进行编译,除非他再次修改组件源代码,否则不需要再重新编译,属于一种AOT的形式。

- 对于用户,它通常直接在Reality World app中进行操作,TA做的事情主要是修改实体的配置数据,当这些数据发生修改之后,这个过程不会涉及代码重新编译,只有Creation Table对数据的内存布局进行重新调整。

所以,尽管整个代码的组织方式看起来很复杂,得益于这种数据分离的机制,编译逻辑相对还是比较简单。

2.3.4.1 AOT

2.3.4.2 机器码在内存中的顺序

由于每个虚拟机内部的组件执行顺序是相对比较固定的,所以我们可以修改组件机器码在内存中的位置,按照组件的执行顺序进行存储,这样组件指令的加载将能够充分利用缓存特性,进一步提升性能。

2.3.4.3 客户端的字节码

有些客户端,如iOS并不永续直接加载机器码,这时候会退化为执行字节码。

当然由于已经关于组件和数据的更多信息,我们仍然可以对端侧的字节码虚拟机进行更多的优化。

此外,由于端侧只计算跟显示相关的逻辑,核心、复杂的计算逻辑还是在后端进行计算,所以性能影响并不大。因为端侧其他逻辑如渲染和物理模拟,仍然是C++代码。

2.3.5 链接和加载

在传统的编译过程中,因为源代码之间相互引用了类型及内存地址,所以它们需要链接在一起。虽然为了实现如增量更新等,能够避免改动一个问题就需要重新编译整个系统,但是链接过程是省不了的,链接的过程即是把各个源代码中相互引用的部分链接起来。

链接的机制对于大型实时系统的限制如下:

- 增加了启动时的加载时间

- 使得程序规模很难伸缩,因为更大规模的程序意味着更大规模的链接时间

- 同时,如果链接文件增多,很难管理到底要加载那些动态库,如果每个动态库只使用一点信息,那系统内存会导致大量的浪费。

虽然静态类型的语言其链接过程只需要发生一次,但是对于动态语言来讲,这样的链接过程需要在加载的时候执行,这增加了应用程序启动加载时的时间。

所以,为了解决大型系统的动态解释问题,我们必须要要能够将程序分成很小的碎片,并且去除相互间的依赖关系,从而彻底去除掉链接这个环境。

具体需要做到几点:

- 源代码之间没有相互类型引用,或者说源代码没有复杂的类型系统,只有基本类型

- 源代码访问的数据地址通过运行时动态分配,即不需要通过编译器实现指定和计算数据地址

- 当然数据的动态分配要足够简单,否则也会增加性能开支,参见Creation Table相关内容

- 源代码要足够碎片化,使得系统可以尽可能加载更少的代码

最终,RealityIS几乎可以完全抛弃动态链接这一部分的计算过程。

2.3.6 组件关系与计算图